Основы машинного обучения (часть 1): РЕГРЕССИЯ — метод перехода к машинному обучению | Дж. Рафид Сиддики, доктор философии | Декабрь 2022 г.

Простое и исчерпывающее введение в линейную, нелинейную и логистическую регрессию Рис. 1. Примеры линейной, нелинейной и логистической регрессии (Источник: автор) Растет интерес к вводным постам по элементарным темам машинного обучения. Итак, я пишу на такие темы в следующих постах, начиная с этого. Эта статья в основном самодостаточна, однако она требует базового понимания линейная алгебра и исчисление .Регрессия

Регрессия — это процесс оценки связи зависимой переменной ( Y ) с одной или несколькими независимыми переменными ( Xi ). Он используется в основном для поиска закономерностей в заданном наборе выборок данных и прогнозирования значения переменной при заданном наборе значений других переменных. Он имеет широкий спектр приложений, от предсказания прогнозов погоды до прогнозов цен на жилье. Значение этих переменных часто является непрерывным, однако существует подмножество методов регрессии, в которых значения могут быть дискретными (например, номинальные/порядковые). Через некоторое время мы увидим различные типы методов регрессии.

Значение этих переменных часто является непрерывным, однако существует подмножество методов регрессии, в которых значения могут быть дискретными (например, номинальные/порядковые). Через некоторое время мы увидим различные типы методов регрессии.

Линейная регрессия

В своей простейшей форме модель регрессии представляет собой линейную функцию, посредством которой значение зависимой переменной может быть получено путем взятия линейной комбинации значений независимых переменных. Например, если данные представлены в двух измерениях, такую модель можно записать в виде уравнения прямой (рис. 2). Уравнение прямой имеет три коэффициента ( a , b и c ). Если мы запишем зависимую переменную y как y = f( x ), тогда мы видим, что нам нужен только наклон (

Теперь давайте возьмем пример набора точек данных, как на рисунке 3. Мы видим, что большинство точки образуют шаблон, похожий на линию, поэтому мы можем смоделировать эти данные как задачу линейной регрессии. В частности, нас интересует нахождение наклона и точки пересечения линии, которая лучше всего соответствует этим точкам данных.

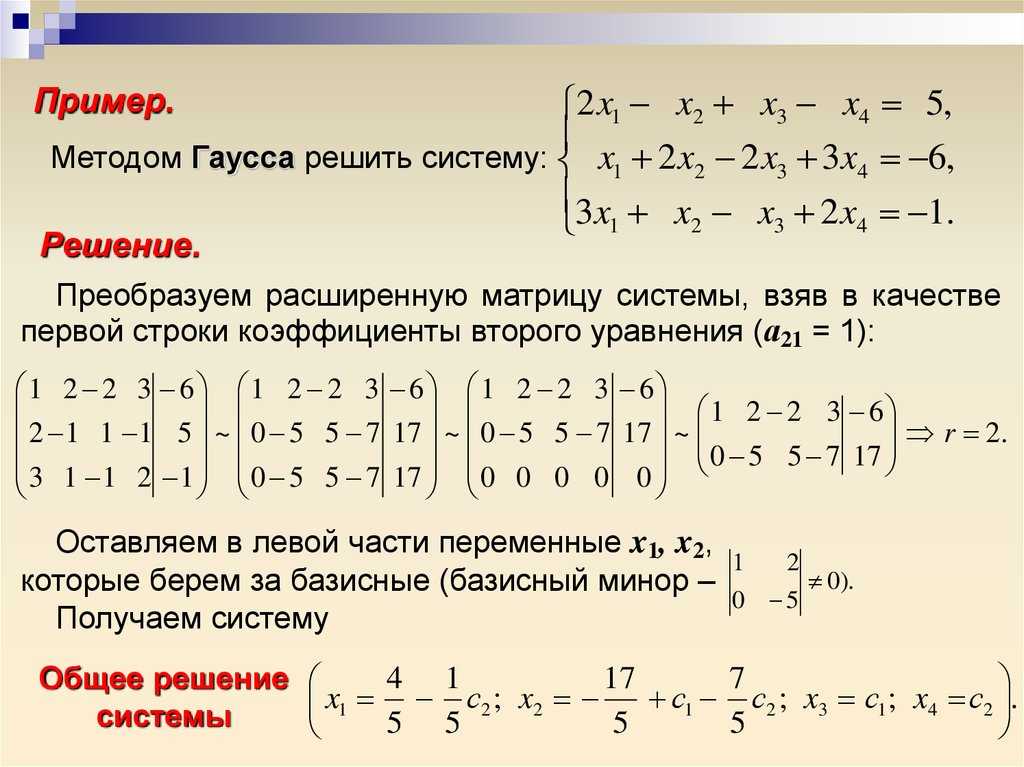

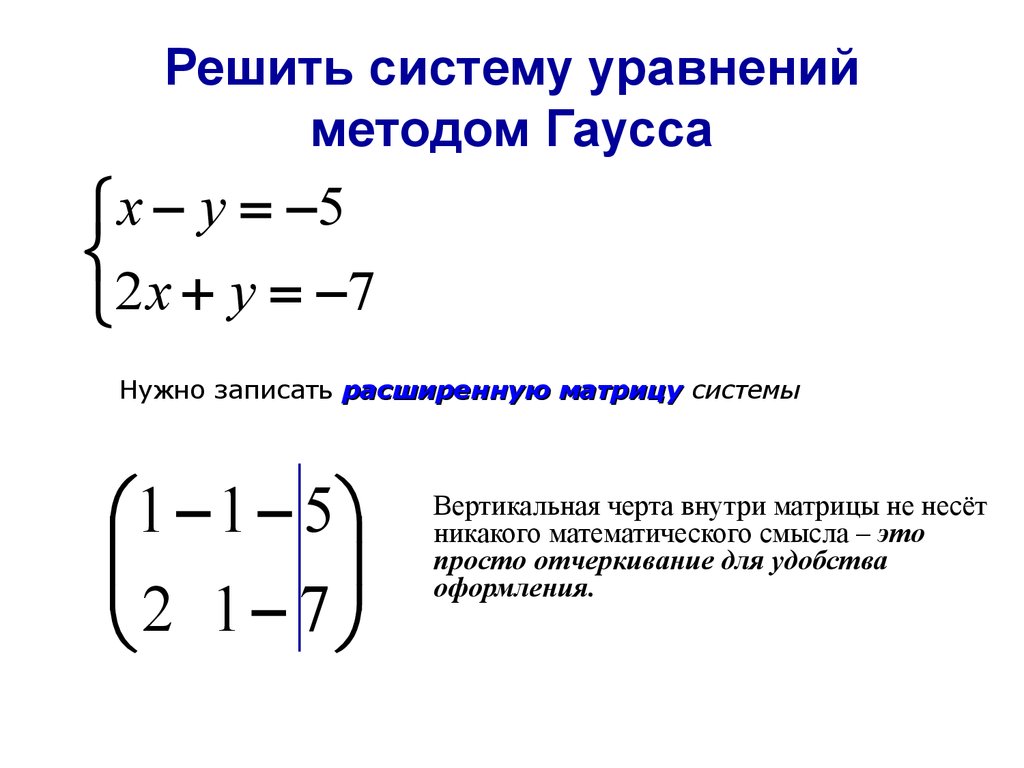

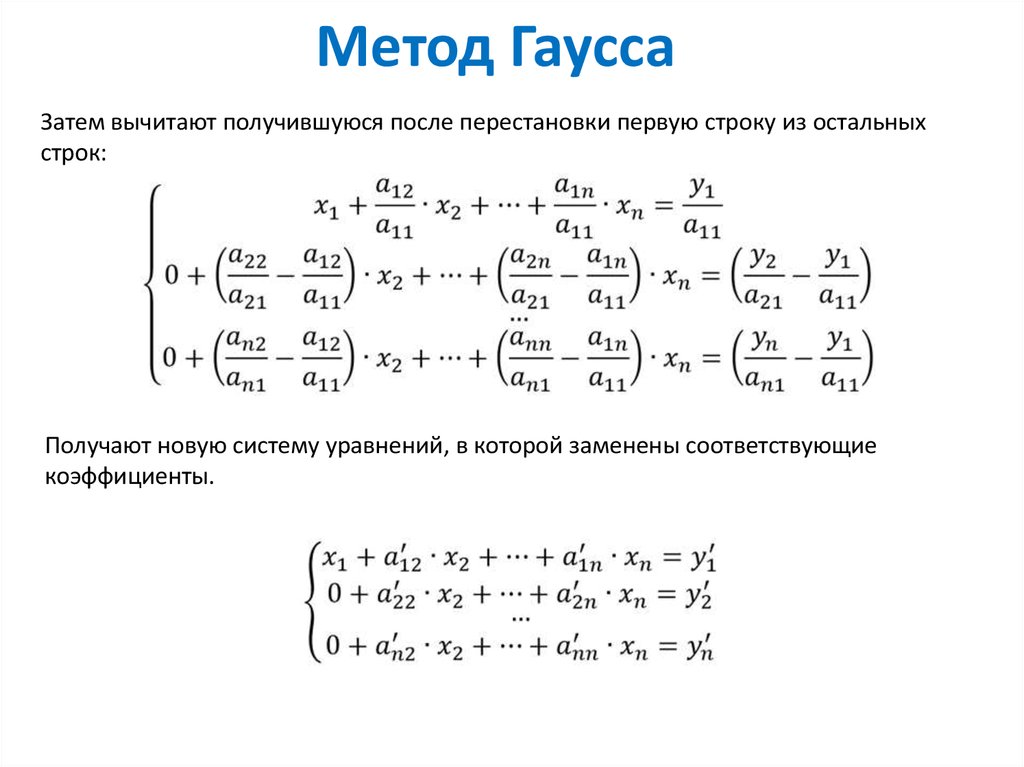

Подбор линии путем решения системы линейных уравнений

Если мы запишем каждую точку в виде линейной комбинации ( y = mx + c ), мы получим набор линейных уравнений. Чтобы найти значения « m» и « c» , нам нужно как минимум два уравнения. И мы видим, что у нас больше двух уравнений, следовательно, наша задача разрешима. В более общем виде мы можем написать набор линейных уравнений с «n» отсчетами и « d» размеры, как на рисунке 4.

Рисунок 4: Решение системы линейных уравнений (Источник: автор) Кроме того, мы можем добавить столбец единиц в X , чтобы сделать продукт возможным и получить соответствующую линейную комбинацию значений. Затем мы можем решить эту систему линейных уравнений ( Y = X w ), взяв обратную матрицу и решив для весов0004 ш’ . Решение обеспечивает наклон и пересечение линии, наилучшей подгонки для заданного набора выборок данных, как показано на рисунке 5.

Кроме того, мы можем добавить столбец единиц в X , чтобы сделать продукт возможным и получить соответствующую линейную комбинацию значений. Затем мы можем решить эту систему линейных уравнений ( Y = X w ), взяв обратную матрицу и решив для весов0004 ш’ . Решение обеспечивает наклон и пересечение линии, наилучшей подгонки для заданного набора выборок данных, как показано на рисунке 5. Обратное матричное решение системы линейных уравнений работает для задач, в которых наименьший шум и нет сингулярностей. Однако в большинстве больших реальных данных эти ограничения могут не соблюдаться. Таким образом, для решения системы линейных уравнений часто используется более надежный и общий метод, называемый 9.0013 Градиентный спуск . Это итеративный метод оптимизации, который стремится найти оптимальную точку (минимум/максимум) целевой функции, постепенно продвигаясь к выходному решению. Более конкретно, вычисляется производная целевой функции (например, d y /d w = X в данном случае) и делается небольшой шаг в направлении оптимальной точки (т.

Линейная регрессия работает в случаях, когда взаимосвязь между переменными является линейной. Однако во многих реальных приложениях это не так. Когда связь между зависимыми и независимыми переменными не может быть выражена в виде линейной комбинации, нам нужно использовать нелинейную регрессию. Набор точек данных в нелинейной форме можно увидеть на рисунке 7.

Рисунок 7: Набор случайно сгенерированных точек данных (Источник: Автор)Полиномиальная регрессия

Нелинейная регрессия может быть различного типа, кривой, замкнутой формы или любой другой формы.

Мы можем построить полином путем перемножения линейных уравнений. Частный случай многочлена 4-й степени показан на рисунке 8. Мы создали сложный многочлен путем умножения четырех простых линейных уравнений с точками пересечения 1, 5, 6 и 12 соответственно. Множитель 0,01

Если мы применим полином к нашим более ранним нелинейным данным, мы увидим, что он может очень хорошо представлять данные, как показано на рисунке 9. Для этих данных должно быть достаточно полинома второго порядка. Формулировка проблемы для нелинейной регрессии такая же, как и для моделирования линейной регрессии. Однако при формировании матрицы весов необходимо вычислять коэффициенты членов более высокого порядка. Как правило, полиномиальная регрессия лучше всего подходит для приложений, в которых данные не являются широко распространенными и представляют собой последовательную прогрессию. Примером таких данных могут быть данные временного ряда от датчика или измерительного устройства.

Регрессия гауссовского процесса

В таких случаях мы изучаем распределение (т. е. среднее значение и дисперсию) в каждой точке вместо одного значения веса. Он может иметь прямое применение в ситуациях, когда сигнал либо зашумлен, либо имеет небольшую степень турбулентности. Моделирование проблемы регрессии как гауссовского процесса позволяет точно прогнозировать сенсорные данные. Сердцем такой регрессии гауссовского процесса является функция ядра. Может существовать множество функций ядра, которые подходят для различных типов данных и приложений. Наиболее распространенной функцией ядра является экспоненциальная функция (например, ядро радиального базиса), которая обеспечивает нелинейную связь между независимыми и зависимыми переменными. Таким образом, целью регрессионного процесса является задача оптимизации, при которой наиболее подходящие значения

В таких случаях мы изучаем распределение (т. е. среднее значение и дисперсию) в каждой точке вместо одного значения веса. Он может иметь прямое применение в ситуациях, когда сигнал либо зашумлен, либо имеет небольшую степень турбулентности. Моделирование проблемы регрессии как гауссовского процесса позволяет точно прогнозировать сенсорные данные. Сердцем такой регрессии гауссовского процесса является функция ядра. Может существовать множество функций ядра, которые подходят для различных типов данных и приложений. Наиболее распространенной функцией ядра является экспоненциальная функция (например, ядро радиального базиса), которая обеспечивает нелинейную связь между независимыми и зависимыми переменными. Таким образом, целью регрессионного процесса является задача оптимизации, при которой наиболее подходящие значения  Полоса вокруг кривой предсказывает, насколько уверенно модель предсказывает значения в определенной точке. Чем уже полоса, тем строже выходные значения.

Полоса вокруг кривой предсказывает, насколько уверенно модель предсказывает значения в определенной точке. Чем уже полоса, тем строже выходные значения.Регулярная логистическая регрессия

До сих пор мы имели дело с задачами непрерывной регрессии, когда значение прогнозируемой выходной переменной является непрерывным числом. Однако во многих реальных приложениях это не так. Например, в случае классификации объектов/признаков мы хотели бы узнать дискретную метку для каждого класса вместо числового значения. Эту проблему можно решить с помощью специального случая регрессии, называемого логистической регрессией. Во всех смыслах это метод регрессии; однако он изменяет выходное значение и целевую функцию таким образом, что выход представляет собой значение вероятности от 0 до 1 для данного класса.

Этого можно достичь, заключив значения входной переменной «x» в сигмовидную функцию. Сигмовидная функция — это нелинейная экспоненциальная функция, которая отображает любое значение «x » в положительное значение от 0 до 1. Остальная часть проблемы регрессии остается прежней. Целевая функция для логистической регрессии и вычисления выходных данных на основе сигмовидной функции дана в приведенном выше уравнении. Точки данных для набора для обучения и набора для тестирования можно увидеть на рисунке 11.

Сигмовидная функция — это нелинейная экспоненциальная функция, которая отображает любое значение «x » в положительное значение от 0 до 1. Остальная часть проблемы регрессии остается прежней. Целевая функция для логистической регрессии и вычисления выходных данных на основе сигмовидной функции дана в приведенном выше уравнении. Точки данных для набора для обучения и набора для тестирования можно увидеть на рисунке 11.

Проблемы классификации требуют обучения на одном наборе данных, в то время как ожидается, что модель будет предсказывать значения для другого набора данных. Поэтому важно, чтобы модель не была слишком жестко ограничена только для тренировочного набора и должна хорошо работать для входных значений, которых не было в тренировочном наборе. Эта проблема называется « переобучение » и устраняется методом, называемым « регуляризация ». Регуляризация — это релаксационный термин в процессе оптимизации, который дает подгонке модели передышку. Это реализуется путем добавления дополнительного члена в целевую функцию, как в приведенном выше уравнении. Коэффициент для таких Регуляризация термин, Лямбда — это весовой коэффициент, обеспечивающий компромисс между точностью и обобщаемостью. Результаты такого регрессионного подбора можно увидеть на рисунке 12.

Регуляризация — это релаксационный термин в процессе оптимизации, который дает подгонке модели передышку. Это реализуется путем добавления дополнительного члена в целевую функцию, как в приведенном выше уравнении. Коэффициент для таких Регуляризация термин, Лямбда — это весовой коэффициент, обеспечивающий компромисс между точностью и обобщаемостью. Результаты такого регрессионного подбора можно увидеть на рисунке 12.

Заключительные замечания

В этой статье мы рассмотрели регрессионный подбор и его типы. Методы линейной, нелинейной и логистической регрессии — это три основных типа проблем регрессии, с которыми вы столкнетесь в реальных приложениях. Регрессия — это простой, но эффективный метод решения некоторых обычных проблем, которые могут возникать во многих прикладных областях. Он также формирует основу для более сложных методов машинного обучения, о которых мы расскажем в следующих статьях.