Google Объектив научился быстро переводить текст со скриншотов

Приложение Google Объектив или Google Lens, если говорить на языке оригинала, давно стало неотъемлемой частью смартфонов многих пользователей. Я даже говорю не про те устройства, где ”Объектив” является частью камеры и интегрирован в штатное приложение. Его можно скачать на любой смартфон и пользоваться тогда, когда захочется. Оно постоянно обрастает новыми функциями и теперь вышла еще одна, которая позволяет переводить текст со скриншотов. Рассказывать о том, когда это может пригодиться, не стоит, лучше показать, как пользоваться новой функцией. Вот этим и займемся. Тем более, что перевод всегда был полезной и актуальной функцией смартфона.

Google Объектив может многое.

Содержание

- 1 Перевод текста со скриншотов

- 2 Как перевести текст со скриншота

- 3 Приложение Google Объектив

- 4 Для чего нужен Google Объектив

Перевод текста со скриншотов

По данным 9to5Google новая функция доступна в пользовательском интерфейсе Google Lens Screenshot UI для устройств под управлением Android 11 и старше. Перевод можно делать, минуя другие программы, просто сделав скриншот. Кнопка перевода станет видимой на предпросмотре изображения. Нажатие на нее позволяет быстро получить перевод текста с картинки.

Перевод можно делать, минуя другие программы, просто сделав скриншот. Кнопка перевода станет видимой на предпросмотре изображения. Нажатие на нее позволяет быстро получить перевод текста с картинки.

Что такое Google Lens, стоит ли его скачать и сколько людей уже сделали это.

Google, как и положено технологическому гиганту, продолжает экспериментировать и предлагать новые функции, чтобы сохранить преимущество на фоне конкурентов. Кроме простого перевода текста силами интерфейса пользователь также может скопировать текст со скриншота и затем можно будет сохранить его или отправить кому-то. В том числе отправка возможна в Google Translate для дальнейшей работы.

В лучших традициях хорошего перевода есть функция загрузки языка для автономной работы. Такая возможность уже давно есть в Google Translate, и это часто выручает. Особенно полезно это в поездках, или когда находишься в том месте, где нет сигнала сети.

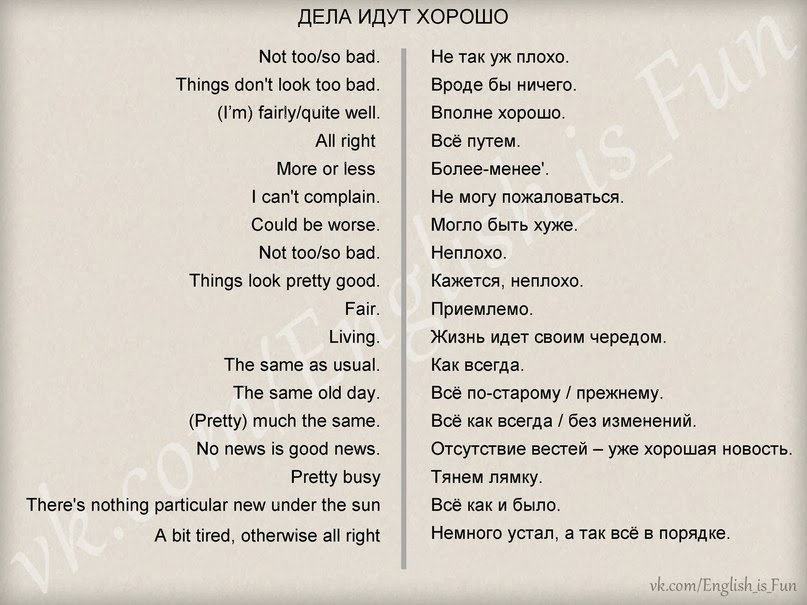

Перевод может быть таким.

К сожалению, пока нет никаких указаний на появление новой функции в Android 10 или более старых его версиях. Зато в появлении ее в Android 12 сомневаться почти не приходится.

Как перевести текст со скриншота

Если вы не можете сделать перевод подобным образом, есть и более простой способ воспользоваться Google Объективом для выполнения этой задачи.

Google учит «Google Объектив» для Android решать математические задачи.

Для начала надо скачать из Google Play или обновить приложение Google Объектив. После этого делаете скриншот, а когда он появится в нижней части экрана, касаетесь его, чтобы открыть для редактирования.

Делаем скриншот и открываем его.

Теперь, когда скриншот перед вами, нажмите ”поделиться” и выберите в списке приложений Google Объектив. Дальше, пользуясь его функциями, вы можете или определить, что изображено на картинке, или перевести текст, нажав на кнопку в левом нижнем углу экрана и выбрав перевод.

Вот и перевод. Кривоватый, но перевод.

Кривоватый, но перевод.

Такие возможности приложения позволят экономить время на переводе текста. Можно, например, сделать скриншот куска переписки и отправить его на перевод. Можно найти что-то на иностранном сайте и понять, о чем сказано в наборе непонятных слов.

Приложение Google Объектив

Само приложение Google Объектив было представлено в рамках Google I/O 2017. Изначально это было даже не приложение, а инструмент, интегрированный в Google Ассистента в смартфонах Google Pixel 2 и Google Pixel XL 2. Только через некоторое время инструмент вышел в широкое пользование. Так он стал частью Google Фото как для смартфонов Pixel, так и для устройств других производителей.

Что покажут на Google I/O 2021

В июне 2018 года оно было выпущено в Google Play и его можно было скачать как отдельное приложение. С тех пор по январь этого года оно было загружено более 500 миллионов раз и имеет очень неплохие отзывы в магазине приложений.

Чтобы инструмент стал еще более популярным, некоторые производители интегрировали его в свои собственные приложения камеры. Так можно получить все преимущества, не перегружая смартфон дополнительными приложениями.

Так можно получить все преимущества, не перегружая смартфон дополнительными приложениями.

Так представили Google Lens миру.

Для чего нужен Google Объектив

Самой полезной функцией Google Объектива является возможность определения чего-либо по фотографии. То есть вы можете навести его на объект, который хотите найти, и в поиске получите то, что может вам пригодиться. Это полезно, когда надо найти что-то редкое или то, название чего не знаешь. А вы пользуетесь Google Объективом?

google translate – Как быстро и легко переводить картинки на ПК?

Вопрос задан

Изменён 2 года 3 месяца назад

Просмотрен 592 раза

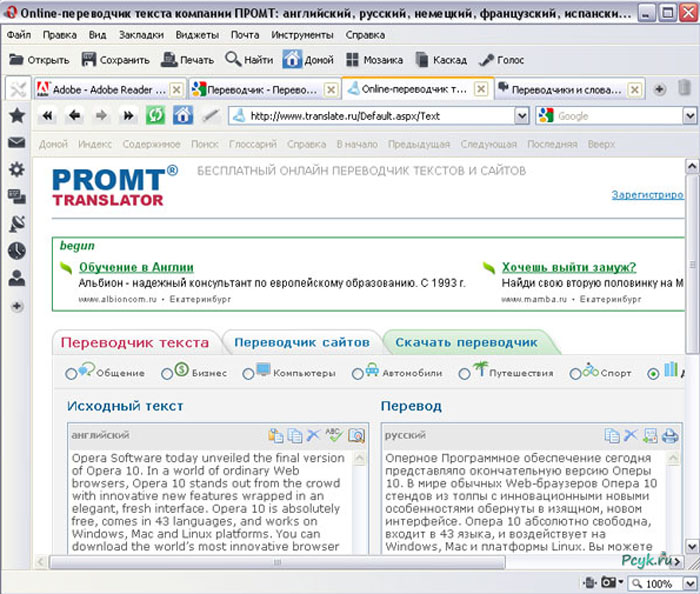

Как я понял из тестов самым лучшим на данный момент переводчиком с картинки является приложение для android, google translate. (yandex-не видит тест, SCREEN TRANSLATOR-не видит тест, New OCR-Думает что m это n, img2txt-коверкает слова)

Но проблема в том что google translate работает только на android. Я пробовал запустить его через BlueStacks но код выдает ошибку e-5105 или e-807. Единственное что более менее работает у меня это связка AirDroid, AutoIt Window Info, AutoIt , Ножницы, Проводник, Opera. Но код написанный на AutoIt работает медленно и не очень стабильно в связке с AirDroid.

(yandex-не видит тест, SCREEN TRANSLATOR-не видит тест, New OCR-Думает что m это n, img2txt-коверкает слова)

Но проблема в том что google translate работает только на android. Я пробовал запустить его через BlueStacks но код выдает ошибку e-5105 или e-807. Единственное что более менее работает у меня это связка AirDroid, AutoIt Window Info, AutoIt , Ножницы, Проводник, Opera. Но код написанный на AutoIt работает медленно и не очень стабильно в связке с AirDroid.

Вариант использовать

https://lens.google.com/

https://cloud.google.com/vision/

https://cloud.google.com/vision/docs/ocr

Мне не подходит так как. Я не хочу привязывать свою карту и платить за это. Бесплатная версия тоже не подходит так как имеет серьезные ограничения.

У кого есть идеи как еще можно организовать это?

- google-translate

1

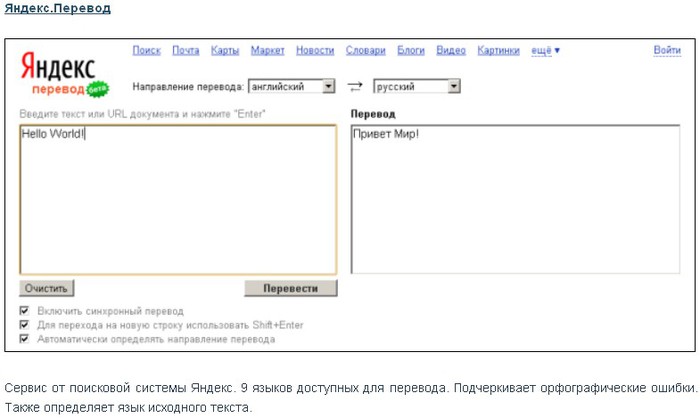

Пару раз была нужна в подобного рода инструменте. Я переводил текст при помощи сервиса

Я переводил текст при помощи сервиса

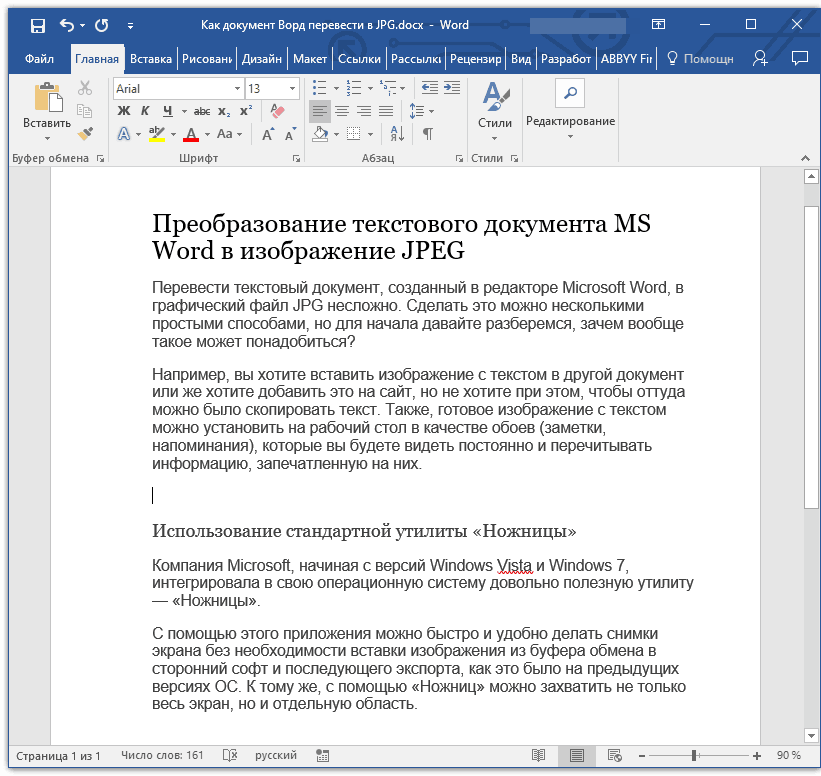

Я выбрал вот такую картинку для перевода:

Открываем сервис, ссылку на который я указал чуть выше, загружаем картинку с текстом, который нужно перевести, выбираем язык текста, который на картинке.

Всё почти готово. Кликаем “Загрузить” и автоматически перенаправляемся на страницу, на которой содержится распознанный текст с картинки.

И дальше уже решайте куда и как загрузить полученный результат. Если нужен перевод – пожалуйста. Нажимаем “Перевести текст” и перенаправляемся на Google Переводчик, который уже сделал то, что нам нужно – перевёл!

Профит!

Зарегистрируйтесь или войдите

Регистрация через Google

Регистрация через Facebook

Регистрация через почту

Отправить без регистрации

Почта

Необходима, но никому не показывается

Отправить без регистрации

Необходима, но никому не показывается

Нажимая на кнопку «Отправить ответ», вы соглашаетесь с нашими пользовательским соглашением, политикой конфиденциальности и политикой о куки

Перевод текста на изображениях — служба поддержки Майкрософт

Доступно в мобильном приложении Office (Microsoft 365) для Android и iOS.

Это действие доступно как часть интеллектуального анализа Deep-scan, который выделяет текст и визуальное содержимое на изображениях, чтобы пользователи могли копировать, делиться, сохранять и выполнять другие действия. Просто нажмите на нужное действие и без проблем повторно используйте контент!

Где эта возможность доступна в мобильном приложении Office (Microsoft 365)?

- org/ListItem”>

Экран прямой трансляции с камеры

Экран редактирования изображения (экран, который появляется после захвата нового изображения)

Поверх PDF-файлов с помощью значка для копирования/передачи текста или изображений

Поверх существующих изображений

Как инициировать перевод изображений?

- org/ListItem”>

Нажмите на текст и выберите нужную текстовую область, которую вы хотите перевести.

Появится набор доступных действий. Нажмите на Перевести . Если вы не видите «Перевести» заранее, нажмите , «Перевод» теперь должен быть виден.

Преобразование текста на нужный язык из набора поддерживаемых языков. Вы можете изменить целевой язык, выбрав Изменить .

org/ListItem”>

Запустите поток глубокого сканирования, щелкнув этот значок над изображениями.

Выполнять такие действия, как копирование, совместное использование, поиск в переведенном тексте.

Совет: Для достижения наилучших результатов используйте изображение хорошего разрешения с четким и простым шрифтом.

Загрузить мобильное приложение Office (Microsoft 365) сейчас: Загрузить для Android.

Где этот опыт доступен в Office Mobile?

Translate доступен как часть Deep-scan, которая доступна в следующих сценариях:

Поверх существующих изображений

Поверх PDF-файлов с помощью значка для копирования/передачи текста или изображений

Экран редактирования изображения (экран, который появляется после захвата нового изображения)

Как инициировать перевод изображений?

Запустите поток глубокого сканирования, выбрав этот значок над изображениями.

Нажмите на текст и выберите нужную текстовую область, которую вы хотите перевести.

Появится набор доступных действий. Нажмите на

Преобразование текста на нужный язык из набора поддерживаемых языков. Вы можете изменить целевой язык, выбрав Изменить .

Выполните такие действия, как Копировать, Поделиться, Прослушать переведенный текст.

Совет: Для достижения наилучших результатов используйте изображение хорошего разрешения с четким и простым шрифтом.

Загрузите мобильное приложение Office (Microsoft 365) сейчас: загрузите для iOS.

Преодоление языкового разрыва с помощью нейронного перевода видео, изображений и текста | Тимур Гаскаров | Яндекс

Предложение автоматического перевода обычного текста на веб-страницах через браузер полезно, но оно не охватывает весь объем информации, опубликованной в Интернете. Правительственные организации в Израиле, например, предпочитают делиться своей информацией в виде изображений, как и многие сайты на корейском, китайском и арабском языках. Технические характеристики товаров, продаваемых в интернет-магазинах, тоже часто размещают в формате изображения.

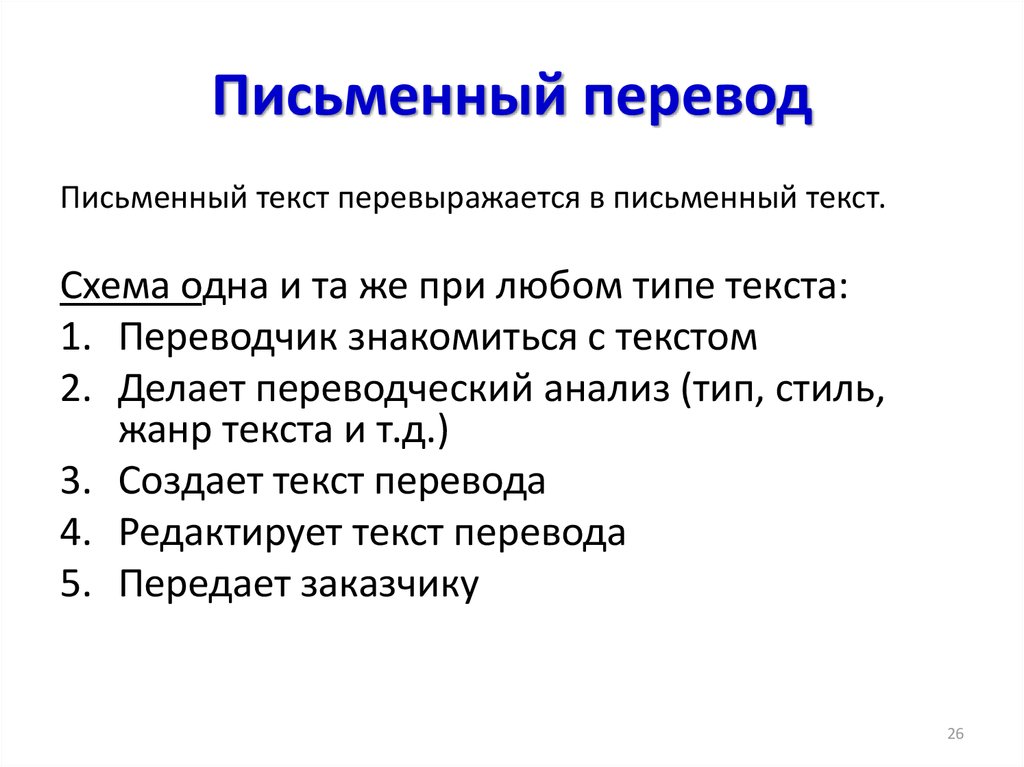

Для перевода текста в изображениях требуется конвейер из трех технологий. Во-первых, компьютерное зрение должно находить и распознавать текст на изображении с помощью процесса, известного как оптическое распознавание символов или OCR. Затем машинный перевод должен переводить текст. И, наконец, переведенный текст должен отображаться поверх оригинала с использованием технологии рендеринга.

И, наконец, переведенный текст должен отображаться поверх оригинала с использованием технологии рендеринга.

Простая реализация этого конвейера состоит в том, чтобы взять исходное изображение, загрузить его в исходном формате из Яндекс.Браузера на сервер Яндекса, выполнить всю работу на стороне сервера и вернуть новую версию изображения с отрендеренным перевод пользователю. Это было бы проще всего для Яндекса, но не очень удобно для пользователя — изображения могут быть довольно большими, их пересылка туда-сюда потребляет трафик и время, что в конечном итоге засоряет пользовательский опыт.

Помня об интересах пользователей, мы выбрали более изощренный способ. Яндекс.Браузер сжимает изображения, делает их черно-белыми и конвертирует в формат WebP, который в среднем на 15–20% компактнее JPEG. В совокупности эти меры позволяют значительно уменьшить размер изображения без существенных потерь в качестве распознавания текста и перевода.

Мы также перенесли этап наложения перевода обратно на изображение на устройство пользователя. Проблема заключалась в том, что отрендеренное изображение с переведенным текстом нужно было наложить поверх оригинального цветного изображения, хранящегося в Яндекс.Браузере. Браузер не может отличить текст от фона на исходном изображении и, следовательно, не может выбрать правильный цвет для переведенного текста. Наше OCR на стороне сервера может распознать текст, но не может сказать, какого цвета он был до того, как изображение было преобразовано в черно-белое.

Проблема заключалась в том, что отрендеренное изображение с переведенным текстом нужно было наложить поверх оригинального цветного изображения, хранящегося в Яндекс.Браузере. Браузер не может отличить текст от фона на исходном изображении и, следовательно, не может выбрать правильный цвет для переведенного текста. Наше OCR на стороне сервера может распознать текст, но не может сказать, какого цвета он был до того, как изображение было преобразовано в черно-белое.

Для решения этой проблемы мы выделили ключевые точки фона и текста на изображении на стороне OCR, а затем отправили их координаты вместе с переводом в Яндекс.Браузер. Затем браузер может использовать эти координаты для определения цветов и выбора правильного цвета для наложения перевода на фон.

Вот так выглядит конечный результат:

Вы можете проверить нашу технологию перевода изображений в работе в Яндекс Браузере на настольном компьютере или устройстве Android, а также в приложении Яндекс.

Потоковое видео становится все более популярным, россияне смотрят все больше образовательных и научно-популярных видео, а также интервью, новостных репортажей и другого контента. Большинство этих видео на других языках, кроме русского, и профессиональный перевод редко предлагается для свежего онлайн-контента. В лучшем случае пользователи получают автоматически сгенерированные субтитры. Чтобы удовлетворить растущий спрос на трансляцию видео из других стран, мы сейчас работаем над тем, чтобы обеспечить автоматический перевод и озвучку видео прямо в Яндекс.Браузере.

Большинство этих видео на других языках, кроме русского, и профессиональный перевод редко предлагается для свежего онлайн-контента. В лучшем случае пользователи получают автоматически сгенерированные субтитры. Чтобы удовлетворить растущий спрос на трансляцию видео из других стран, мы сейчас работаем над тем, чтобы обеспечить автоматический перевод и озвучку видео прямо в Яндекс.Браузере.

Как и в случае с изображениями, одного машинного перевода недостаточно, чтобы преодолеть языковой барьер для наших пользователей. Качество видеоперевода сильно зависит от качества распознавания и синтеза речи. Работа над этими технологиями для разговорного помощника Алисы на базе ИИ помогла нам быстро внедрить их для перевода видео в Яндекс.Браузер.

Шаг 1. Распознавание речи и предварительная обработка текста

На входе видео с озвучкой. Это может быть обучающее видео с одним спикером, интервью с двумя людьми или даже дискуссия с несколькими участниками. Преобразование неструктурированной речи в текст приведет к бесструктурной последовательности слов — без запятых, точек или логической группировки слов в предложения или предложений в абзацы. И если мы пропустим такой текст через алгоритм машинного перевода, результатом будет чистый GIGO (мусор на входе, мусор на выходе). Вот почему мы не просто преобразуем речь в текст без применения специальной нейросети, которая отсеивает мусор, группирует слова в смысловые сегменты и расставляет знаки препинания.

И если мы пропустим такой текст через алгоритм машинного перевода, результатом будет чистый GIGO (мусор на входе, мусор на выходе). Вот почему мы не просто преобразуем речь в текст без применения специальной нейросети, которая отсеивает мусор, группирует слова в смысловые сегменты и расставляет знаки препинания.

При переводе видео мы опираемся не только на голос, но и на субтитры. Мы не применяем нашу технологию распознавания речи к тем видео, в которых уже есть субтитры. Текст, написанный человеком, обычно имеет лучшее качество, чем текст, созданный с помощью технологии автоматического распознавания речи, также известной как ASR. Однако если субтитры были сгенерированы автоматически, мы игнорируем их и используем распознавание речи.

Субтитры, даже если они были написаны человеком и добавлены вручную, должны обрабатываться нейронной сетью, чтобы удалить все, что может сбивать с толку при синтезе голоса, например, описание звуков (аплодисменты, сирены и т. д.) или имена говорящих перед их словами.

Ручные субтитры также могут быть разбиты на произвольные сегменты, а не на логические фразы, поэтому мы должны убедиться, что сгенерированная речь соответствует правильному смыслу, который может быть разбросан по нескольким строкам.

Две строки субтитров на этом скриншоте сегментированы неправильно. Технология автоматизированного перевода перевела бы эти строки как есть, но наша нейронная сеть реконструирует фактические сегменты фразы из контекста, и окончательный результат синтеза речи выглядит так:0003

Так что этот довольно крут.

На самом деле это метод диагностики.

Шаг 2. Биометрия

Теперь, когда у нас есть правильные сегменты текста с отметками времени, мы определяем пол говорящего для каждой части текста, чтобы применить соответствующий синтезированный голос. За переведенным голосом за кадром легче следить, когда у говорящих разные голоса. В дальнейшем синтезированный голос будет соответствовать не только полу говорящего, но и его личному тону, высоте, тембру и другим характеристикам. Наша технология синтеза речи в настоящее время поддерживает два голоса — мужской и женский — и в разработке находятся другие.

Наша технология синтеза речи в настоящее время поддерживает два голоса — мужской и женский — и в разработке находятся другие.

Шаг 3. Машинный перевод

Этот шаг вполне стандартный, но с одной важной отличительной особенностью. Помимо многих других факторов, мы добавляем в модель перевода информацию о поле говорящего, чтобы обеспечить правильную грамматику в конечном результате. Благодаря этой информации фраза «Я нашел прекрасного супруга», произнесенная соответственно женихом и невестой, будет выглядеть на русском языке так:

Невеста :

Я нашла замечательного супруга.

Я нашла замечательного супруга.

Жених :

Я нашла замечательную супругу.

Я нашол замечательную супругу.

Окончание каждого слова в предложении, кроме Я («Я»), меняется в зависимости от того, кто говорит (женщина-невеста или мужчина-жених) и к кому они относятся (мужчина-жених или женщина-невеста). Формы слов во многих языках различаются в зависимости от пола говорящего и человека или объекта, к которому они относятся. Передача этой информации в модель перевода гарантирует, что говорящие продолжают правильно обращаться к себе и обращаться к другим в переведенной версии.

Формы слов во многих языках различаются в зависимости от пола говорящего и человека или объекта, к которому они относятся. Передача этой информации в модель перевода гарантирует, что говорящие продолжают правильно обращаться к себе и обращаться к другим в переведенной версии.

Шаг 4. Синтез речи

При синтезе переведенной речи необходимо учитывать фактор длины. Русские тексты длиннее английских в целом. Разница может варьироваться в среднем от 10% до 30%, а это означает, что в более длинных видео существует риск того, что англоговорящий и наш русский голос могут серьезно рассинхронизироваться. Для синхронизации двух речевых потоков вместо простого ускорения русской звуковой дорожки мы используем временные метки, которые создаем при анализе исходной речи. Эти временные метки сообщают нам, какие фразы произносятся в определенные моменты, и помогают более точно синхронизировать речевые потоки.

Синтез речи — сложный процесс, состоящий из двух основных этапов. Во-первых, нейронные сети создают спектрограмму, визуальное представление звуковых частот для каждой фразы. Во-вторых, другие нейронные сети преобразуют спектрограммы в звук. Временные метки помогают нам сгенерировать спектрограмму нужной продолжительности на первом этапе. Затем спектрограмма переведенной речи сокращается до соответствия оригиналу, в первую очередь за счет удаления ненужных пауз между фразами и словами, и только когда этого недостаточно, алгоритм ускоряет речь.

Во-вторых, другие нейронные сети преобразуют спектрограммы в звук. Временные метки помогают нам сгенерировать спектрограмму нужной продолжительности на первом этапе. Затем спектрограмма переведенной речи сокращается до соответствия оригиналу, в первую очередь за счет удаления ненужных пауз между фразами и словами, и только когда этого недостаточно, алгоритм ускоряет речь.

Шаг 5. Уведомления

Видеотрансляция — это каскад ресурсоемких технологий, которые запускаются последовательно. Чтобы запустить огромные нейронные сети-трансформеры, требуется время, даже если они работают параллельно на нескольких графических процессорах. Перевод часового видео изначально занял у нас полчаса. Мы успешно оптимизировали весь процесс и значительно ускорили механизм перевода, но весь процесс по-прежнему занимает минуты, а не доли секунды.

Поскольку мы продолжаем работать над мгновенным переводом, в случаях, когда это занимает больше нескольких секунд, мы предлагаем нашим пользователям уведомить их, когда их перевод будет готов. После запроса озвучивания выбранного видео они могут закрыть вкладку и вернуться на страницу, когда Яндекс Браузер уведомит их о том, что их видео доступно для просмотра.

После запроса озвучивания выбранного видео они могут закрыть вкладку и вернуться на страницу, когда Яндекс Браузер уведомит их о том, что их видео доступно для просмотра.

Конвейер видеотрансляции

Посмотрите переведенный образец лекции сооснователя Википедии Джимми Уэйлса на Яндексе (оригинал здесь). Этот фрагмент иллюстрирует как потенциал нашей технологии, так и вызовы, с которыми еще предстоит столкнуться.

Наша цель — помочь людям преодолеть языковой барьер и открыть для себя новый, интересный контент там, где еще нет профессионального перевода. Мы продолжим совершенствовать наш движок видеоперевода, чтобы расширить возможности для наших пользователей.

В настоящее время синхронный перевод доступен для английских видео на популярных платформах, таких как YouTube, Vimeo, Facebook и других. Он работает в настольной и Android-версиях Яндекс.Браузера, а также в приложении Яндекс для Android и iOS.

API Яндекс Переводчика доступен через платформу Yandex Cloud.