$$f(x_0 + h) = f(x_0) + \color{#348FEA}{\left[D_{x_0} f \right]} (h) + \bar{\bar{o}} \left(\left| \left| h\right|\right|\right),$$

где $\color{#348FEA}{\big[D_{x_0} f\big]}$ — дифференциал функции $f$: линейное отображение из мира $x$-ов в мир значений $f$. Грубо говоря, он превращает «малое приращение $h=\Delta x$» в «малое приращение $\Delta f$» («малые» в том смысле, что на о-малое можно плюнуть):

$$f(x_0 + h) – f(x_0)\approx\color{#348FEA}{\left[D_{x_0} f \right]} (h)$$

Отметим, что дифференциал зависит от точки $x_0$, в которой он берётся: $\color{#348FEA}{\left[D_{\color{red}{x_0}} f \right]} (h)$. Под $\vert\vert h\vert\vert$ подразумевается норма вектора $h$, например корень из суммы квадратов координат (обычная евклидова длина).

Давайте рассмотрим несколько примеров и заодно разберёмся, какой вид может принимать выражение $\color{#348FEA}{\big[D_{x_0} f\big]} (h)$ в зависимости от формы $x$.

Можно заметить, что здесь, по аналогии с примерами, где $x$ — скаляр и где $x$ — вектор (и $f(x)$ — скалярная функция), получилось на самом деле скалярное произведение градиента функции $f$ по переменным $X_{ij}$ и приращения. Этот градиент мы записали для удобства в виде матрицы с теми же размерами, что матрица $X$.

В примерах выше нам дважды пришлось столкнуться с давним знакомцем из матанализа: градиентом скалярной функции (у нескалярных функций градиента не бывает). Напомним, что градиент $\color{#FFC100}{\nabla_{x_0} f}$ функции в точке $x_0$ состоит из частных производных этой функции по всем координатам аргумента. При этом его обычно упаковывают в ту же форму, что и сам аргумент: если $x$ — вектор-строка, то и градиент записывается вектор-строкой, а если $x$ — матрица, то и градиент тоже будет матрицей того же размера. Это важно, потому что для осуществления градиентного спуска мы должны уметь прибавлять градиент к точке, в которой он посчитан.

Как мы уже имели возможность убедиться, для градиента скалярной функции $f$ выполнено равенство

$$ \left[D_{x_0} f \right] (x-x_0) = \langle\color{#FFC100}{\nabla_{x_0} f}, x-x_0\rangle, $$

где скалярное произведение — это сумма попарных произведений соответствующих координат (да-да, самое обыкновенное).

Посмотрим теперь, как выглядит дифференцирование для функций, которые на выходе выдают не скаляр, а что-то более сложное.

Примеры конкретных форм $\big[D_{x_0} f\big] (h)$, где $f$ — это вектор или матрица$f(x) = \begin{pmatrix} f(x_1)\ \vdots\ f(x_m) \end{pmatrix}$, $x$ — вектор. Тогда

$$ f(x_0 + h) – f(x_0) = \begin{pmatrix} f(x_{01} + h_1) – f(x_{01})\ \vdots \ f(x_{0m} + h_m) – f(x_{0m}) \end{pmatrix} \approx \begin{pmatrix} f'(x_{01}) h_1\ \vdots \ f'(x_{0m}) h_m \end{pmatrix} = \begin{pmatrix} f'(x_{01}) \ \vdots \ f'(x_{0m}) \end{pmatrix} \odot h. $$

В последнем выражении происходит покомпонентное умножение:

$$\color{#348FEA}{\big[D_{x_0} f\big]} (h) = f'(x_0) \odot h = h \odot f'(x_0)$$

$f(X) = XW$, где $X$ и $W$ — матрицы.

Тогда

Тогда$$f(X_0 + H) – f(X_0) = (X_0 + H) W – X_0 W = H W,$$

то есть

$$\color{#348FEA}{\big[D_{X_0} f\big]} (H) = H W$$

$f(W) = XW$, где $X$ и $W$ — матрицы. Тогда

$$f(W_0 + H) – f(W_0) = X(W_0 + H) – XW_0 = X H,$$

то есть

$$\color{#348FEA}{\big[D_{W_0} f\big]} (H) = X H$$

$f(x) = (f_1(x),\ldots,f_K(x))$ — вектор-строка, $x = (x_1,\ldots,x_D)$ — вектор-строка. Тогда

$$ \color{#348FEA}{\big[D_{x_0} f\big]}(h) = \left(\sum_j \left. \frac{\partial f_1}{\partial y_j} \right|_{y=x_0}h_j, \ldots, \sum_j \left. \frac{\partial f_K}{\partial y_j} \right|_{y=x_0}h_j \right) = \\ = h \cdot \begin{pmatrix} \left. \frac{\partial f_1}{\partial y_1} \right|_{y=x_0} & \ldots & \left. \frac{\partial f_k}{\partial y_1} \right|_{y=x_0} \\ \vdots & & \vdots \\ \left. \frac{\partial f_1}{\partial y_D} \right|_{y=x_0} & \ldots & \left.

Матрица, выписанная в предпоследней выкладке, — это знакомая вам из курса матанализа матрица Якоби.

Простые примеры и свойства матричного дифференцирования

Производная константы. Пусть $f(x) = a$. Тогда

$$f(x_0 + h) – f(x_0) = 0,$$

то есть $\color{#348FEA}{\big[D_{x_0} f\big]}$ — это нулевое отображение. А если $f$ — скалярная функция, то и $\color{#FFC100}{\nabla_{x_0} f} = 0.$

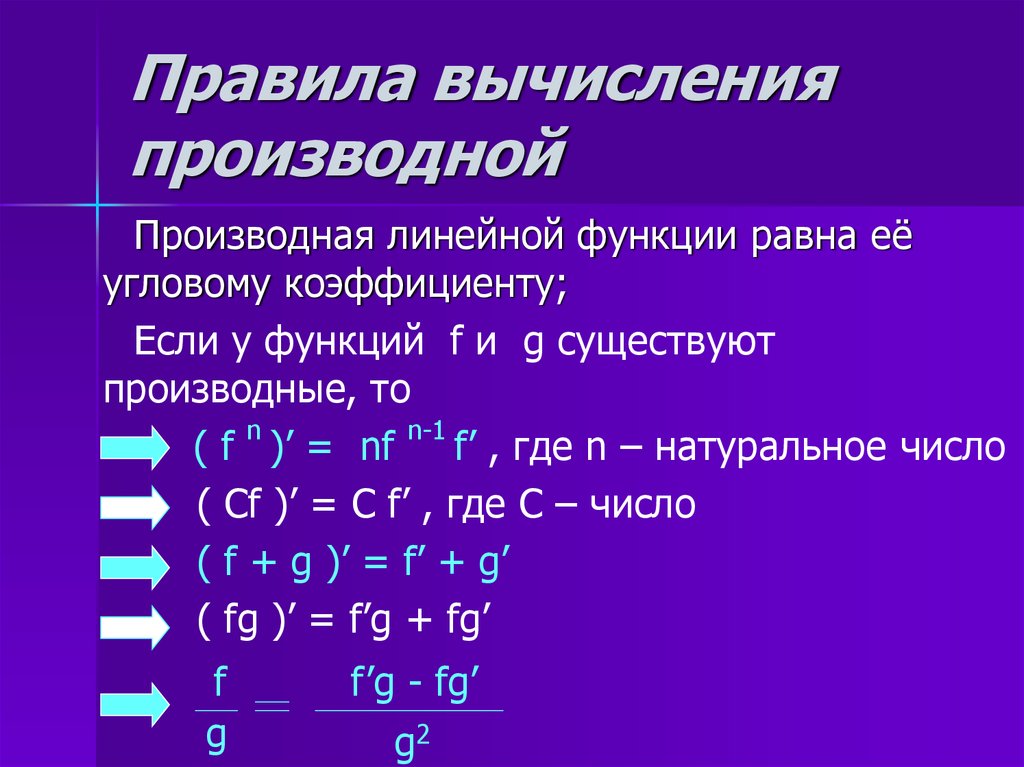

Производная линейного отображения.

$$f(x_0 + h) – f(x_0) = f(x_0) + f(h) – f(x_0) = f(h)$$

Поскольку справа линейное отображение, то по определению оно и является дифференциалом $\color{#348FEA}{\big[D_{x_0} f\big]}$. Мы уже видели примеры таких ситуаций выше, когда рассматривали отображения умножения на матрицу слева или справа.

Если $f$ — (скалярная) линейная функция, то она представляется в виде $\langle a, v\rangle$ для некоторого вектора $a$ — он и будет градиентом $f$.

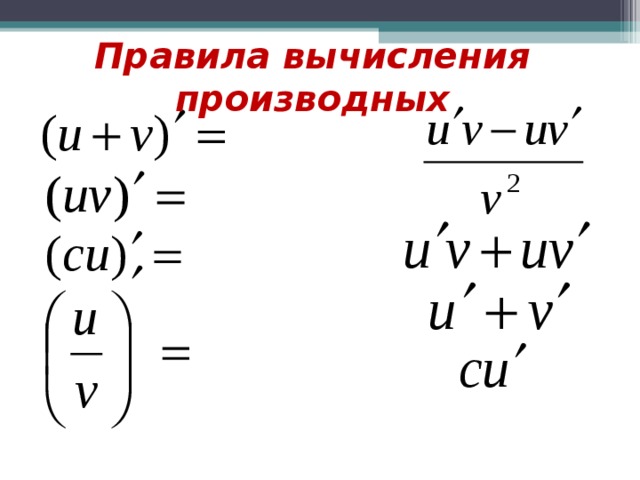

Если $f$ — (скалярная) линейная функция, то она представляется в виде $\langle a, v\rangle$ для некоторого вектора $a$ — он и будет градиентом $f$.Линейность производной. Пусть $f(x) = \lambda u(x) + \mu v(x)$, где $\lambda, \mu$ — скаляры, а $u, v$ — некоторые отображения, тогда

$$\color{#348FEA}{\big[D_{x_0} f\big]} = \lambda \color{#348FEA}{\big[D_{x_0} u\big]} + \mu \color{#348FEA}{\big[D_{x_0} v\big]}$$

Попробуйте доказать сами, прежде чем смотреть доказательство.$$f(x_0 + h) – f(x_0) = (\lambda u(x_0 + h) + \mu v(x_0 + h)) – (\lambda u(x_0) + \mu v(x_0)) =$$

$$ = \lambda(u(x_0 + h) – u(x_0)) + \mu(v(x_0 + h) – v(x_0)) \approx $$

$$\approx \lambda \color{#348FEA}{\big[D_{x_0} u\big]}(h) + \mu \color{#348FEA}{\big[D_{x_0} v\big]}(h)$$

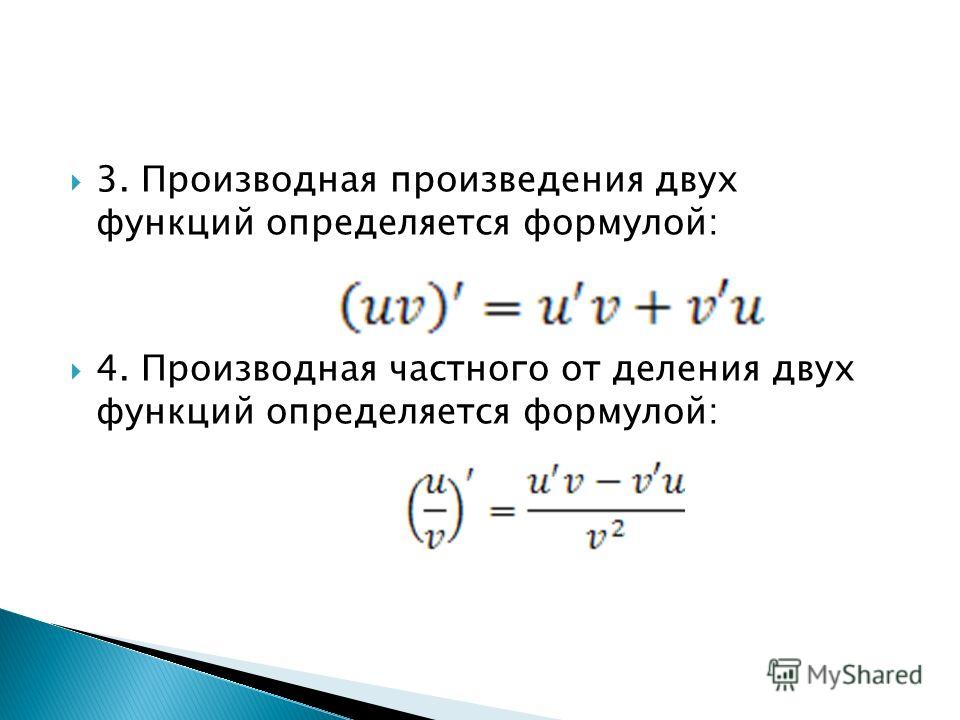

Производная произведения. Пусть $f(x) = u(x) v(x)$, где $u, v$ — некоторые отображения, тогда

$$\color{#348FEA}{\big[D_{x_0} f\big]} = \color{#348FEA}{\big[D_{x_0} u\big]} \cdot v(x_0) + u(x_0) \cdot \color{#348FEA}{\big[D_{x_0} v\big]}$$

Попробуйте доказать сами, прежде чем смотреть доказательство.

Обозначим для краткости $x = x_0 + h$. Тогда

$$u(x)v(x) – u(x_0)v(x_0) = u(x)v(x) – u(x_0)v(x) + u(x_0)v(x) – u(x_0)v(x_0) =$$

$$ (u(x) – u(x_0))v(x) + u(x_0)(v(x) – v(x_0))\approx $$

$$\approx \color{#348FEA}{\big[D_{x_0} u\big]}(h) \cdot v(x) + u(x_0)\cdot \color{#348FEA}{\big[D_{x_0} v\big]}(h)$$

И всё бы хорошо, да в первом слагаемом $v(x)$ вместо $v(x_0)$. Придётся разложить ещё разок:

$$\color{#348FEA}{\big[D_{x_0} u\big]}(h) \cdot v(x) \approx $$

$$\color{#348FEA}{\big[D_{x_0} u\big]}(h) \cdot \left(v(x_0) + \color{#348FEA}{\big[D_{x_0} v\big]}(h) + o(\vert\vert h\vert\vert)\right) =$$

$$\color{#348FEA}{\big[D_{x_0} u\big]}(h) \cdot v(x_0) + \bar{\bar{o}}\left(\vert\vert h\vert\vert\right)$$

Это же правило сработает и для скалярного произведения:

$$\color{#348FEA}{\big[D_{x_0} \langle u, v\rangle\big]} = \langle\color{#348FEA}{\big[D_{x_0} u\big]}, v\rangle + \langle u, \color{#348FEA}{\big[D_{x_0} v\big]}\rangle$$

В этом нетрудно убедиться, повторив доказательство или заметив, что в доказательстве мы пользовались лишь дистрибутивностью (= билинейностью) умножения.

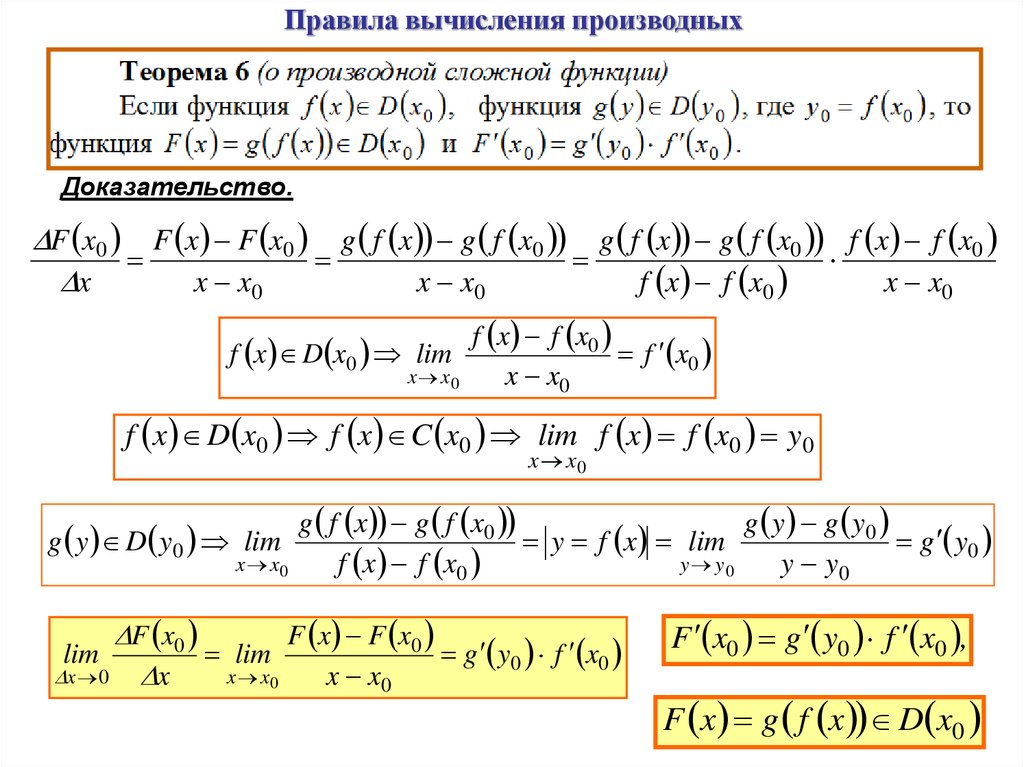

Производная сложной функции. Пусть $f(x) = u(v(x))$. Тогда

$$f(x_0 + h) – f(x_0) = u(v(x_0 + h)) – u(v(x_0)) \approx $$

$$\approx\left[D_{v(x_0)} u \right] (v(x_0 + h) – v(x_0)) \approx \left[D_{v(x_0)} u \right] \left( \left[D_{x_0} v\right] (h)\right)$$

Здесь $D_{v(x_0)} u$ — дифференциал $u$ в точке $v(x_0)$, а $\left[D_{v(x_0)} u \right]\left(\ldots\right)$ — это применение отображения $\left[D_{v(x_0)} u \right]$ к тому, что в скобках. Итого получаем:

$$\left[D_{x_0} \color{#5002A7}{u} \circ \color{#4CB9C0}{v} \right](h) = \color{#5002A7}{\left[D_{v(x_0)} u \right]} \left( \color{#4CB9C0}{\left[D_{x_0} v\right]} (h)\right)$$

Важный частный случай: дифференцирование перестановочно с линейным отображением. Пусть $f(x) = L(v(x))$, где $L$ — линейное отображение. Тогда $\left[D_{v(x_0)} L \right]$ совпадает с самим $L$ и формула упрощается:

$$\left[D_{x_0} \color{#5002A7}{L} \circ \color{#4CB9C0}{v} \right](h) = \color{#5002A7}{L} \left( \color{#4CB9C0}{\left[D_{x_0} v\right]} (h)\right)$$

Простые примеры вычисления производной

Вычислим дифференциал и градиент функции $f(x) = \langle a, x\rangle$, где $x$ — вектор-столбец, $a$ — постоянный вектор.

Вычислить производную можно непосредственно:

$$f(x_0 + h) – f(x_0) = \langle a, x_0 + h\rangle – \langle a, x_0\rangle = \langle a, h\rangle$$

Но можно и воспользоваться формулой дифференциала произведения:

$$\color{#348FEA}{\big[D_{x_0} \langle a, x\rangle\big]} (h) = $$

$$ =\langle\color{#348FEA}{\big[D_{x_0} a\big]}(h), x\rangle + \langle a, \color{#348FEA}{\big[D_{x_0} x\big]}(h)\rangle$$

$$= \langle 0, x\rangle + \langle a, h\rangle = \langle a, h\rangle$$

Сразу видно, что градиент функции равен $a$.

Вычислим производную и градиент $f(x) = \langle Ax, x\rangle$, где $x$ — вектор-столбец, $A$ — постоянная матрица.

Попробуйте вычислить сами, прежде чем смотреть решение.Снова воспользуемся формулой дифференциала произведения:

$$\color{#348FEA}{\big[D_{x_0} \langle Ax, x\rangle\big]}(h) = $$

$$ = \langle\color{#348FEA}{\big[D_{x_0} Ax\big]}(h), x_0\rangle + \langle Ax_0, \color{#348FEA}{\big[D_{x_0} x\big]}(h)\rangle$$

$$= \langle Ah, x_0\rangle + \langle Ax_0, h\rangle$$

Чтобы найти градиент, нам надо это выражение представить в виде $\langle ?, h\rangle$.

2,$$

2,$$что, конечно, меньше нуля для любой ненулевой $H$.

World Web Math: Правило произведения

World Web Math: Правило произведения Мы хотели бы иметь возможность брать производные от произведений функций производные которых мы уже знаем. Например f ( x )=( x -2)( x -1) произведение двух функций, u ( x ) = x -2 и v ( x ) = x -1, оба из которых производные, которые, как мы знаем, равны 1. Было бы неплохо, если бы производная от продукт был продуктом производной, как это для сумм? К сожалению, это не случай;и в этом достаточно простом случае легко видеть, что производная продукта НЕ продукт производные. Хотя это наивное предположение было неверным, мы все же можем выяснить, что производная продукта должна быть. Помните: когда интуиция подводит, применить определение. Учитывать

Хороший способ запомнить правило продукта для дифференциации: первая производная от второй плюс вторая умноженная на производное от первого». Сейчас это может показаться неинтуитивным, но посмотрите, и через несколько дней вы будете повторять это и себе.

Другой способ запомнить приведенный выше вывод — подумать о продукт u ( x ) v ( x ) как площадь прямоугольника шириной u ( x ) и высотой против ( х ). Изменение площади равно d ( uv ), что указано на рисунке ниже.

Алгебраически,

Алгебраически,- Мы можем использовать правило произведения, чтобы подтвердить тот факт, что производная

постоянная функция, умноженная на константу, умноженная на производную от

функция. Для c константа,

Является ли это существенно проще, чем умножение полиномиальный и дифференцирующий непосредственно – вопрос мнения; решите сами.

- Если f и g являются дифференцируемыми функциями

такое, что f (2)=3, f ´(2)=-1, г (2)=-5 и г ´(2)=2, то каково значение

( фг )´(2)?

- С

что такое г ´( x )?

- Если f , g и h дифференцируемы, используйте

правило произведения, чтобы показать, что

Как следствие, покажите, что Это частный случай цепного правила.

- Найти dy/dx где

[email protected] Последнее изменение: 11 февраля 2003 г.

Правило произведения высших производных

Эта статья посвящена правилу дифференцирования , то есть правилу дифференцирования функции, выраженной через другие функции, производные которых известны.

Посмотреть другие правила дифференцирования

Содержание

- 1 Заявление

- 1.1 Одностороннее исполнение

- 2 Частные случаи

- 3 Связанные правила

- 3.1 Подобные правила в исчислении одной переменной

- 3.2 Подобные правила в многомерном исчислении

- 3.3 Подобные правила в высшей математике

- 4 Значение

- 4.1 Качественное и экзистенциальное значение

- 4.

2 Вычислительная значимость

2 Вычислительная значимость

Заявление

| Тип версии | Заявление||

|---|---|---|

| конкретная точка, именованные функции | Это утверждает, что если и являются раз дифференцируемыми функциями при , то поточечное произведение также раз дифференцируемо при , и мы имеем: Здесь обозначает производную от (с и т. д.), обозначает производную от , коэффициент. Это те же самые коэффициенты, которые появляются в разложении . | |

| общая точка, именованные функции, обозначение точки | Если и являются функциями одной переменной, то везде, где правая часть имеет смысл, верно следующее: | Если и являются функциями одной переменной, то везде, где правая часть имеет смысл, верно следующее: |

| Чистая нотация Лейбница | Предположим, что и обе переменные функционально зависят от . Затем |

Односторонний вариант

Существуют аналоги каждого из утверждений с односторонними производными. Заполните позже

Заполните позже

Частные случаи

| Стоимость | Формула для |

|---|---|

| 1 | (это обычное правило продукта для дифференциации). |

| 2 | . |

| 3 | . |

| 4 | |

| 5 |

Связанные правила

Подобные правила в исчислении одной переменной

- Правило произведения для дифференцирования

- Цепное правило для высших производных

- Цепная линейка для дифференцирования

- Повторное дифференцирование является линейным

Аналогичные правила в исчислении многих переменных

- Правило произведения для старших частных производных

Аналогичные правила в высшей математике

- Биномиальная формула для степеней вывода

Значение

Качественное и экзистенциальное значение

Каждая из версий имеет свое качественное значение:

| Тип исполнения | Значение |

|---|---|

| конкретная точка, именованные функции | Это говорит нам о том, что если и оба раза дифференцируемы в точке, то и . |

| общая точка, именованные функции, обозначение точки | Это говорит нам о том, что если и оба времени дифференцируемы на открытом интервале, то и . |

| общая точка, именованные функции, бесточечная нотация | Это показывает, что поведение определяется природой производных (вплоть до ) от и . В частности, если и обе непрерывные функции на интервале, то и . |

Расчетная значимость

Каждый из вариантов имеет свою расчетную значимость:

| Тип версии | Значение |

|---|---|

| конкретная точка, именованные функции | Это говорит нам о том, что знание значений (в смысле числовых значений ) и в точке позволяет нам вычислить значение, вставив в формулу и выполнив ряд умножений и сложений. |

| общая точка, именованные функции | Это говорит нам о том, что знание общих выражений для и позволяет нам вычислить общее выражение для . |

Тогда

Тогда

Если $f$ — (скалярная) линейная функция, то она представляется в виде $\langle a, v\rangle$ для некоторого вектора $a$ — он и будет градиентом $f$.

Если $f$ — (скалярная) линейная функция, то она представляется в виде $\langle a, v\rangle$ для некоторого вектора $a$ — он и будет градиентом $f$.

2,$$

2,$$

2 Вычислительная значимость

2 Вычислительная значимость