Гарячі вакансії в Україні, термінова робота на порталі Jobs.ua

Сторінка 1 з 2

Вакансії 1-20 з 31

Показати: Всіза 7 днівза 14 днівза 30 днівза 3 місяціза рік

Вінницький обласний центр зайнятості VIP Крижопіль

Освіта: середньо-спеціальна Досвід роботи: не вимагається Графік роботи: повний робочий деньВимоги: Відповідальність, вміння працювати в колективі. Бажання працювати на результат.

Обов’язки:…

Dolls men`s club VIP Київ

Клуб Dolls запрошує на работу ТАНЦІВНИЦЬ!!

Дівчата від 18 років, привабливої.

..

..✔ Швачка 15 000

Гаряча Термінова

Автогардероб VIP Київ

Освіта: не має значення Досвід роботи: обов’язковий Графік роботи: повний робочий день Зп від 15000грн

Зп від 15000грнВінницький обласний центр зайнятості VIP Вінниця

Освіта: середньо-спеціальна Досвід роботи: не вимагаєтьсяОбов’язки: Позмінне несення служби згідно посадової інструкції в…

✔ Вантажник 10 000

грн. + %Гаряча Термінова

Вінницький обласний центр зайнятості VIP Вінниця

Вимоги, побажання: можливе забезпечення житлом.

Обов’язки: Виконання…

Пересувне відділення поштового зв’язку надає поштові послуги населенню сіл…

Вінницький обласний центр зайнятості VIP Ямпіль (Вінницька обл.

Вимоги,…

Сучасний заклад освіти запрошує в свою креативну команду Помічника керівника/адміністратора

.

ОН Клінік VIP Черкаси

Освіта: повна вища Досвід роботи: обов’язковий Графік роботи: повний робочий деньОпис вакансії

«ОН Клінік» — це мережа…

ОН Клінік VIP Харків

Освіта: повна вища Досвід роботи: обов’язковий Графік роботи: повний робочий деньМережа медичних центрів «ОН Клінік» запрошує до співпраці Web-аналитик.

VIP компанії в Україні:

Майстерня декору «Marmolata» VIP Київ

Освіта: повна вища Досвід роботи: не вимагається Графік роботи: повний робочий деньСмакі Макі VIP Львів

Освіта: не має значення Досвід роботи: бажано Графік роботи: позмінна робота ..

..Смакі Макі VIP Львів

Освіта: не має значення Досвід роботи: не вимагається Графік роботи: позмінна робота«Смакі Макі» — прогресивна та амбітна компанія, яка 7 років дбає аби смачні та свіжі суші, роли та піца у…

Психологічна студія дитячого розвитку «Сова» VIP Київ

Освіта: повна вища Досвід роботи: від року Графік роботи: повний робочий деньВимоги, побажання: спеціальна освіта, досвід роботи з особливими дітьми, що мають діагнози: аутизм, ЗМР,.

..

..✔ Логопед 15 000

грн.Гаряча Термінова

Психологічна студія дитячого розвитку «Сова» VIP Київ

Освіта: повна вища Досвід роботи: від року Графік роботи: повний робочий деньВимоги, побажання: Спеціальна освіта, досвід роботи. Співпрацюємо із студентами, навчаємо, берем під.

..

..Ліцей «Прем’єр» VIP Київ

Освіта: повна вища Досвід роботи: від року Графік роботи: часткова зайнятістьСучасний заклад освіти запрошує в свою креативну команду?

??Вчителя музики

…

Ліцей «Прем’єр» VIP Київ

Освіта: повна вища Досвід роботи: від року Графік роботи: часткова зайнятістьСучасний заклад освіти запрошує в свою креативну команду

Вчителя історії

.

..

..«Приватний ліцей «Нест Екедемі» Київської області» VIP Крюківщина

Освіта: повна вища Досвід роботи: бажано Графік роботи: часткова зайнятістьЗапршуємо до співпраці у приватний ліцей Nest Academy педагога математики для учнів 7-9 класів та учнів мішаної форми…

ЄБФ Червона Калина VIP Харків

Освіта: не має значення Досвід роботи: не вимагається Графік роботи: вільний графік роботиТребования, пожелания: ввічливість, відповідальність, чуйність працьовитість.

Обязанности: праця на…

Ліцей «Прем’єр» VIP Київ

Освіта: повна вища Досвід роботи: від року Графік роботи: часткова зайнятістьСучасний заклад освіти запрошує в свою креативну команду?

??Вчителя музики

…

-

12

Ctrl →

1 з 2

ГАРЯЧІ ВАКАНСІЇ – АКТУАЛЬНО НА ВСІ 100%

Свіжі вакансії передових роботодавців країни чекають вас на цих сторінках. Більше не треба втрачати дорогоцінний час в пошуках нових пропозицій. Якщо ви досвідчений пошукач, якого не задовольняє «робота на один раз» і який прагне чогось нового, вважайте, що вам пощастило.

Більше не треба втрачати дорогоцінний час в пошуках нових пропозицій. Якщо ви досвідчений пошукач, якого не задовольняє «робота на один раз» і який прагне чогось нового, вважайте, що вам пощастило.

Свіжі вакансії з’являються на ринку праці стрімко і так само швидко зникають. Фахівці порталу Jobs.ua оперативно перевіряють в ручну і оновлюють поточні пропозиції щодня.

Знаючи нашу принциповість і вміння працювати, провідні компанії розміщують всі свої свіжі вакансії в першу чергу на сторінках нашого порталу. За 20 років роботи наша компанія змогла допомогти знайти «своє місце під сонцем» понад п’ятнадцяти мільйонам пошукачів. Тому ми щиро сподіваємося, що і ви зможете з нашою допомогою реалізувати свої бажання щодо працевлаштування.

Не впадайте у відчай, якщо сьогодні робота вашої мрії не зустрілася на життєвому шляху. Свіжі вакансії оновлюються щодня, це обов’язково допоможе знайти вам саме те, що необхідно.

Перелік для пошуку роботи: сайти та платформи

🇺🇦 ВзаємоДія

Не можеш знайти? Телефонуй +38 044 300 28 48

Інформація

Сайти та платформи

Робота у містах України

Telegram канали

Сервіси для фрілансерів

Інформація

- Розділ інформаційного порталу Ужгороду з вакансіями для переселенців (кухарі, перукарі, лікарі, кур’єри, майстри манікюра).

- Список відкритих позицій для роботи в академічній сфері.

- Таблиця з відкритими позиціями за кордоном.

Сайти та платформи

- Jooble — знайти роботу в країні, яка тебе прихистила

- 62 Best Remote Jobs Websites in 2022 – перелік ресурсів пошуку віддаленої роботи

- Компанія Kyndryl – remote вакансії, початковий рівень

- SokolRoom – шукайте готові вакансії та розміщуйте свої резюме, отримуйте тимчасову роботу.

- UA Talents – платформа працевлаштування для українців, які перемістилися до інших міст України чи за кордон

- Hireforukraine – робота для українців по всьому світу

- Indeed – англомовний сайт для пошуку роботи по всьому світі

- unjobs.org – вакансій UN та інших міжнародних організацій

- Glassdoor – сайт для пошуку роботи по всьому світі

- BazaIt – англомовна платформа для пошуку вакансій в сфері IT

- preply.

com – робота для викладачів

com – робота для викладачів - Робота на Upwork (Як зареєструватися та користуватися ресурсом)

- Jobkast – сервіс для пошуку remote роботи.

- https://iwork.in.ua/ каталог актуальних Українських бізнесів, сервісів, виробництв, які мають можливість працювати під час війни

- Happymonday – збираємо актуальні вакансії з можливістю працювати віддалено або в європейських містах.

- Понад 2500 віддалених вакансій – jobs.dou

- Sap – портал вакансій

- Adecco — допомагає українцям знайти роботу там, де їм потрібно

- Jobs4ukraine — консолідована інформація по роботі для українців

- Imagine Ukraine – платформа, яка поєднує біженців з війни в Україні з волонтерами та міжнаціональними компаніями

- remoteukraine.org — некомерційна платформа, яка допомагає кваліфікованим українським спеціалістам продовжувати працювати, де б вони не перебували

- Job Aid Ukraine – англомовна платформа працевлаштування для українців, які вимушено залишили свої домівки

- Opportunities for Architects and Creators from Ukraine – Large database of opportunities for Ukrainian architects.

- Sokolroom.com – Роботодавці і виконавці шукають один одного

- robota.ua – Робота працює на перемогу в Україні – robota.uarobota.ua для пошуку роботи вдома та закордоном: https://t.me/robotaua_now_bot

- The female factor – Europe’s first job platform for female talents

- UA Hospitality – платформa для українців, які шукають роботу у сфері гостинності в Англії / ЄС / віддаллено

- EASE WORK — cервіс для пошуку роботи українським ІТ-спеціалістам

- Робота для студентів без досвіду – платформа STUDLAVA

- Work.ua – Сайт пошуку роботи №1 в Україні

- Праця UA – Волонтерський некомерційний ТГ-канал з актуальними вакансіями в Україні та світі.

Робота у містах України

Пошук роботи в Одесі

Полтава

🇺🇦 Робота на Тернопільщині

🇺🇦 Робота на Тернопільщині Даний телеграм-канал створено для актуальних вакансій у Тернопільській області, у зв’язку з вимушеною тимчасовою міграцією населення у країні. Роботодавці можуть залишати заявки тут: в Telegram-bot @work_Ternopil_bot If you have Telegram, you can view and join 🇺🇦 Робота на Тернопільщині right away.

Telegram канали

Jobs for Ukrainians

Бот для розмiщення та пошуку вакансiй

Remote job

Телеграм-канал (англійською)

Пошук роботи по всьому світу

Навзаєм

Дайджести, вакансії, навчальні матеріали

UNI WORK

Вакансії, стажування й кар’єрні можливості для студентів КНУ, КНЕУ, Могилянки, КПІ та всіх-всіх університетів

Для студентів: вакансії, стажування, курси

Базу збирає вакансії

Вакансії по всій Європі і в Україні. Aвтор каналу @elenabazu

Пошук і розміщення вакансій різних профілів

В стиле digital

Телеграм-канал (digital для SMM, копірайтерів, стратегів, таргетологів і модераторів)

Digital вакансії SMM, Макркетинг, Копірайтинг та інші.

Goodjob

Канал з вакансіями та порадами з пошуку роботи

Канал з ресурсами по пошуку роботи та навчання для тих, хто постраждав від війни

Workado

Віддалена та гібридна робота

Віддалені вакансії для Українців

Vilnius IT

Чат IT спеціалістів в Литві

Чат для ІТ спецалістів у Литві

Happy Monday

Телеграм-канал і сайт, де інформують про актуальні вакансії

Кар‘єрна платформа з рекомендаціями щодо компаній, вакансій, шляхів розвитку кар‘єри.

UA Job Now

Допомога в працевлаштуванні під час війни. В Україні, Європі та дистанційно. Тільки оплачувана робота.

Допомога в працевлаштуванні під час війни. В Україні, Європі та дистанційно.

Крезюме

Телеграм канал з вакансіями у творчих сферах

Вакансії в креативних індустріях

Zaichenko team

Tg канал – підбірки вакансій у сферах журналістики, дизайну, маркетингу та IT.

Допомога с пошуком роботи

Lobby X

Чат з робочими та волонтерськими можливостями в Україні

Робота в Медіа і ІТ

A-play

вакансії у сферах: ▪️ менеджмент;▪️ маркетинг;▪️ адмін. і офісний персонал;▪️ особисті помічники.

GRC.UA

Найактуальніші вакансії, заходи та новини з пошуку роботи в Україні.

UПошуку

Платформа для пошуку роботи в Європі.

Job for People

Робота для Українців

PRACYA | РОБОТА ДЛЯ УКРАЇНЦІВ🇺🇦

Допомога в працевлаштуванні В: Україні 🇺🇦 та Країнах ЕС 🇪🇺

CASES Jobs

Вакансії в галузі креативних індустрій та IT

JobPoint

Бот допомагає знайти роботу та кандидатів у потрібній географічній точці

Robota. ua

ua

t.me/robota_ua_bot

Бот для пошуку руботи

Сервіси для фрілансерів

- Fiverr

- freelancehunt.ua

- modsquad.com

- zeerk.com

- speedlancer.com

- Freelancer

- contently.com

- seoclerk.com

- freeup.net

- Native Teams

- Upwork

- writers.work

- getcredo.com

- talenteum.com

- kabanchik.ua

Допомога з працевлаштуванням для фрілансерів з України

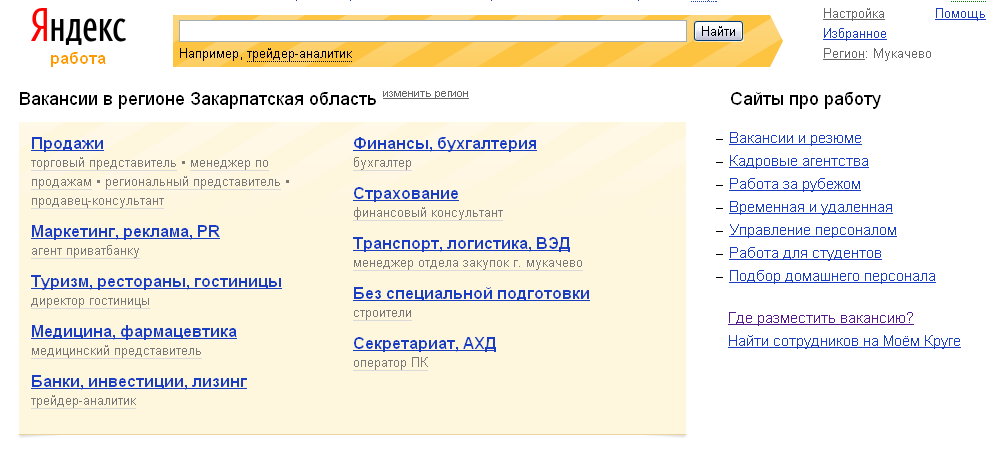

Пауки и роботы поисковых систем

Поисковые системы по большей части являются объектами, которые полагаются на автоматизированных программных агентов, называемых пауками, сканерами, роботами и ботами. Эти боты ищут контент в Интернете и на отдельных веб-страницах. Эти инструменты являются ключевыми элементами работы поисковых систем.

(Пожалуйста, ознакомьтесь с маркетинговыми услугами Metamend в поисковых системах).

Чтобы иметь возможность индексировать Интернет, поисковым системам нужен инструмент, который может посещать веб-сайты; перемещаться по веб-сайтам; различать информацию о веб-сайте; решить, о чем сайт; и добавьте эти данные в его index. Этот инструмент также должен иметь возможность следить за лидами или ссылками с одного веб-сайта на другой, чтобы он мог бесконечно продолжать собирать информацию и узнавать об Интернете. Если он выполняет свою работу должным образом, то поисковая система имеет хорошую, ценную базу данных или индекс и будет предоставлять релевантные результаты по запросу посетителей.

Этот инструмент также должен иметь возможность следить за лидами или ссылками с одного веб-сайта на другой, чтобы он мог бесконечно продолжать собирать информацию и узнавать об Интернете. Если он выполняет свою работу должным образом, то поисковая система имеет хорошую, ценную базу данных или индекс и будет предоставлять релевантные результаты по запросу посетителей.

К сожалению, инструменты, от которых зависят поисковые системы при добавлении контента в свои базы данных, не являются ни передовыми, ни невероятно мощными. Роботы поисковых систем имеют очень ограниченную функциональность, аналогичную возможностям ранних веб-браузеров с точки зрения того, что они могут понять на веб-странице. Из видимой им информации эти пауки извлекают такую информацию, как заголовки страниц, метатеги и метаданные, а также текстовый контент для включения в индекс или базу данных поисковой системы.

Если вы хотите получить представление о том, что видят веб-сайты поисковые системы, возьмите в руки браузер Internet Explorer версии 3 или Netscape Navigator. Это не всегда красиво. Но, как и ранние браузеры, боты поисковых систем просто не знают, как делать определенные вещи. Эти боты не понимают фреймы, флэш-ролики, изображения или JavaScript. Они не могут нажимать какие-либо кнопки на веб-сайте, поэтому, если нет статической ссылки, по которой они могли бы перейти, они не перейдут по ней. Они не могут перемещаться по раскрывающимся меню и не могут выполнить поиск на вашем веб-сайте, чтобы найти контент. Они также, вероятно, будут остановлены на своем пути при попытке проиндексировать динамически сгенерированный веб-сайт или веб-сайт, использующий навигацию JavaScript.

Это не всегда красиво. Но, как и ранние браузеры, боты поисковых систем просто не знают, как делать определенные вещи. Эти боты не понимают фреймы, флэш-ролики, изображения или JavaScript. Они не могут нажимать какие-либо кнопки на веб-сайте, поэтому, если нет статической ссылки, по которой они могли бы перейти, они не перейдут по ней. Они не могут перемещаться по раскрывающимся меню и не могут выполнить поиск на вашем веб-сайте, чтобы найти контент. Они также, вероятно, будут остановлены на своем пути при попытке проиндексировать динамически сгенерированный веб-сайт или веб-сайт, использующий навигацию JavaScript.

Как работают роботы поисковых систем?

Думайте о роботах поисковых систем как об очень простых автоматизированных программах для поиска данных, путешествующих по сети в поисках информации и ссылок. Они поглощают только то, что видят, и хотя картинка стоит тысячи слов для человека, она ничего не стоит для поисковой системы. Они могут только читать и понимать текст, и то только в том случае, если он изложен в формате, адаптированном к их потребностям. Обеспечение того, чтобы они могли получить доступ и прочитать все содержимое веб-сайта, должно быть основной частью любого стратегия поисковой оптимизации .

Обеспечение того, чтобы они могли получить доступ и прочитать все содержимое веб-сайта, должно быть основной частью любого стратегия поисковой оптимизации .

Когда веб-страница отправляется в поисковую систему, URL-адрес добавляется в очередь веб-сайтов для посещения ботами поисковой системы. Даже если вы не отправляете напрямую веб-сайт или веб-страницы на веб-сайте, большинство роботов найдут контент на вашем веб-сайте , если на него ссылаются других веб-сайтов. Это часть процесса, называемого построением взаимных ссылок. Это одна из причин, почему так важно повысить ссылочную популярность веб-сайта и получить ссылки с других тематических сайтов на ваш. Это должно быть частью любой маркетинговой стратегии веб-сайта, которую вы выбираете.

Когда бот поисковой системы заходит на веб-сайт, он должен проверить, есть ли у вас файл robots.txt. Этот файл используется, чтобы сообщить роботам, какие области вашего сайта им недоступны. Как правило, это могут быть каталоги, содержащие файлы, с которыми роботу не нужно иметь дело. Некоторые боты будут игнорировать эти файлы. Однако все поисковые роботы ищут файл. Он должен быть на каждом сайте, даже если он пустой. Это всего лишь одна из вещей, которые ищут поисковые системы.

Как правило, это могут быть каталоги, содержащие файлы, с которыми роботу не нужно иметь дело. Некоторые боты будут игнорировать эти файлы. Однако все поисковые роботы ищут файл. Он должен быть на каждом сайте, даже если он пустой. Это всего лишь одна из вещей, которые ищут поисковые системы.

Роботы хранят список всех ссылок, которые они находят на каждой посещаемой ими странице, и переходят по этим ссылкам на другие веб-сайты. Первоначальная концепция Интернета заключалась в том, что все будет органично связано друг с другом, подобно гигантской модели отношений. Этот принцип до сих пор является частью кода, определяющего, как передвигаются роботы.

Умная часть поисковых систем начинается на следующем этапе. Сбор всех данных, полученных ботами, является частью построения индекса поисковой системы или базы данных. Эта часть индексации веб-сайтов и веб-страниц исходит от инженеров поисковых систем, которые разрабатывают правила и алгоритмы, используемые для оценки и оценки информации, полученной ботами поисковых систем. После того, как веб-сайт добавлен в базу данных поисковой системы, информация становится доступной для клиентов, которые запрашивают поисковую систему. Когда пользователь поисковой системы вводит запрос в поисковую систему, поисковая система выполняет множество шагов, чтобы убедиться, что она предоставляет то, что, по ее оценке, является лучшим, наиболее релевантным ответом на вопрос.

После того, как веб-сайт добавлен в базу данных поисковой системы, информация становится доступной для клиентов, которые запрашивают поисковую систему. Когда пользователь поисковой системы вводит запрос в поисковую систему, поисковая система выполняет множество шагов, чтобы убедиться, что она предоставляет то, что, по ее оценке, является лучшим, наиболее релевантным ответом на вопрос.

Как поисковые системы читают ваш сайт?

Когда бот поисковой системы посещает веб-сайт, он читает весь видимый текст на веб-странице, содержимое различных тегов в исходном коде (тег заголовка, метатеги, теги Dublin Core, теги комментариев, теги alt , теги атрибутов, содержимое и т. д.), а также текст гиперссылок на веб-странице. Из контента, который он извлекает, поисковая система решает, о чем веб-сайт и веб-страница. Есть много факторов, используемых для выяснения того, что имеет ценность, а что имеет значение. Каждая поисковая система имеет свой собственный набор правил, стандартов и алгоритмов для оценки и обработки информации. В зависимости от того, как бот был настроен поисковой системой, различные фрагменты информации собираются, взвешиваются, индексируются, а затем добавляются в базу данных поисковой системы.

В зависимости от того, как бот был настроен поисковой системой, различные фрагменты информации собираются, взвешиваются, индексируются, а затем добавляются в базу данных поисковой системы.

Манипулирование ключевыми словами в этих элементах веб-страницы является частью так называемой поисковой оптимизации .

После добавления информация становится частью процесса ранжирования поисковой системы и каталога. Когда посетитель поисковой системы отправляет свой запрос, поисковая система просматривает свою базу данных, чтобы предоставить окончательный список, который отображается на странице результатов.

Базы данных поисковых систем обновляются в разное время. Как только веб-сайт находится в базе данных поисковой системы, боты будут продолжать посещать его регулярно, чтобы отслеживать любые изменения, внесенные на страницы веб-сайтов, и обеспечивать наличие самых последних данных. Количество посещений веб-сайта будет зависеть от того, как поисковая система настраивает свои посещения, которые могут различаться в зависимости от поисковой системы. Однако чем активнее веб-сайт, тем чаще его посещают. Если веб-сайт часто меняется, поисковая система будет чаще отправлять ботов. Это также верно, если веб-сайт чрезвычайно популярен или имеет большой трафик.

Однако чем активнее веб-сайт, тем чаще его посещают. Если веб-сайт часто меняется, поисковая система будет чаще отправлять ботов. Это также верно, если веб-сайт чрезвычайно популярен или имеет большой трафик.

Иногда боты не могут получить доступ к веб-сайту, который они посещают. Если веб-сайт не работает, бот может не получить к нему доступ. Когда это происходит, веб-сайт может не быть переиндексирован, а если это происходит неоднократно, веб-сайт может упасть в рейтинге.

Что такое файл robots.txt? Рекомендации по синтаксису Robot.txt

Что такое файл robots.txt?

Robots.txt — это текстовый файл, который веб-мастера создают, чтобы проинструктировать веб-роботов (обычно роботов поисковых систем) о том, как сканировать страницы на их веб-сайте. Файл robots.txt является частью протокола исключения роботов (REP), группы веб-стандартов, которые регулируют, как роботы сканируют Интернет, получают доступ и индексируют контент, а также предоставляют этот контент пользователям. REP также включает в себя такие директивы, как метароботы, а также инструкции для страницы, подкаталога или сайта о том, как поисковые системы должны обрабатывать ссылки (например, «follow» или «nofollow»).

REP также включает в себя такие директивы, как метароботы, а также инструкции для страницы, подкаталога или сайта о том, как поисковые системы должны обрабатывать ссылки (например, «follow» или «nofollow»).

На практике файлы robots.txt указывают, могут ли определенные пользовательские агенты (программное обеспечение для веб-сканирования) сканировать части веб-сайта. Эти инструкции по обходу указываются путем «запрета» или «разрешения» поведения определенных (или всех) пользовательских агентов.

Базовый формат:User-agent: [имя user-agent]Disallow: [строка URL не сканируется]

Вместе эти две строки считаются полным файлом robots.txt — хотя один файл robots может содержать несколько строк пользовательских агентов и директив (например, запрещает, разрешает, задержки сканирования и т. д.).

В файле robots.txt каждый набор директив агента пользователя отображается как отдельный набор , разделенных разрывом строки:

В файле robots. txt с несколькими директивами агента пользователя каждое правило запрещает или разрешает только применяется к пользовательскому агенту (агентам), указанным в этом конкретном наборе, разделенном разрывом строки. Если файл содержит правило, которое применяется более чем к одному пользовательскому агенту, сканер будет обращать внимание (и следовать указаниям) только на наиболее конкретные группа инструкций.

txt с несколькими директивами агента пользователя каждое правило запрещает или разрешает только применяется к пользовательскому агенту (агентам), указанным в этом конкретном наборе, разделенном разрывом строки. Если файл содержит правило, которое применяется более чем к одному пользовательскому агенту, сканер будет обращать внимание (и следовать указаниям) только на наиболее конкретные группа инструкций.

Вот пример:

Msnbot, discobot и Slurp вызываются специально, поэтому эти пользовательские агенты будут только обращать внимание на директивы в своих разделах файла robots.txt. Все остальные пользовательские агенты будут следовать директивам в группе пользовательских агентов: *.

Пример robots.txt:

Вот несколько примеров robots.txt в действии для сайта www.example.com:

URL-адрес файла robots.txt: www.example.com/robots.txt Блокировка всех поисковых роботов для всего контентаUser-agent: * Disallow: /

Использование этого синтаксиса в файле robots. txt предписывает всем поисковым роботам не сканировать какие-либо страницы на www.example. com, включая домашнюю страницу.

txt предписывает всем поисковым роботам не сканировать какие-либо страницы на www.example. com, включая домашнюю страницу.

Агент пользователя: * Disallow:

Использование этого синтаксиса в файле robots.txt указывает поисковым роботам просканировать все страницы на www.example.com, включая главную страницу.

Блокировка определенного поискового робота из определенной папкиАгент пользователя: Googlebot Запретить: /example-subfolder/

Этот синтаксис указывает только сканеру Google (имя пользовательского агента Googlebot) не сканировать любые страницы, которые содержать строку URL www.example.com/example-subfolder/.

Блокировка определенного поискового робота на определенной веб-страницеАгент пользователя: Bingbot Запретить: /example-subfolder/blocked-page.html

Этот синтаксис указывает только сканеру Bing (имя пользовательского агента Bing) избегать сканирование конкретной страницы по адресу www. example.com/example-subfolder/blocked-page.html.

example.com/example-subfolder/blocked-page.html.

Как работает файл robots.txt?

Поисковые системы выполняют две основные функции:

- Сканирование сети в поисках контента;

- Индексирование этого контента, чтобы его можно было предоставить тем, кто ищет информацию.

Для обхода сайтов поисковые системы следуют ссылкам, чтобы перейти с одного сайта на другой — в конечном счете, сканируя многие миллиарды ссылок и веб-сайтов. Такое поведение сканирования иногда называют «пауками».

После перехода на веб-сайт, но до его сканирования поисковый робот будет искать файл robots.txt. Если он найдет его, сканер сначала прочитает этот файл, прежде чем продолжить просмотр страницы. Поскольку файл robots.txt содержит информацию о как должна сканировать поисковая система, найденная там информация будет указывать дальнейшие действия сканера на этом конкретном сайте. Если файл robots.txt , а не содержит какие-либо директивы, запрещающие деятельность пользовательского агента (или если на сайте нет файла robots. txt), он продолжит сканирование другой информации на сайте.

txt), он продолжит сканирование другой информации на сайте.

Другие необходимые сведения о файле robots.txt:

(более подробно обсуждается ниже)

Чтобы файл robots.txt можно было найти, его необходимо поместить в каталог верхнего уровня веб-сайта.

Robots.txt чувствителен к регистру: файл должен называться «robots.txt» (не Robots.txt, robots.TXT и т. д.).

Некоторые пользовательские агенты (роботы) могут игнорировать ваш файл robots.txt. Это особенно характерно для более гнусных поисковых роботов, таких как вредоносные роботы или скребки адресов электронной почты.

Файл /robots.txt является общедоступным: просто добавьте /robots.txt в конец любого корневого домена, чтобы увидеть директивы этого сайта (если этот сайт имеет файл robots.txt!). Это означает, что любой может видеть, какие страницы вы сканируете или не хотите, поэтому не используйте их для сокрытия личной информации пользователя.

Каждый поддомен в корневом домене использует отдельные файлы robots.txt. Это означает, что и у blog.example.com, и у example.com должны быть свои собственные файлы robots.txt (по адресу blog.example.com/robots.txt и example.com/robots.txt).

Как правило, рекомендуется указывать местоположение любых карт сайта, связанных с этим доменом, в нижней части файла robots.txt. Вот пример:

Идентификация критических предупреждений robots.txt с помощью Moz Pro

Функция сканирования сайта Moz Pro проверяет ваш сайт на наличие проблем и выделяет срочные ошибки, которые могут помешать вам появиться в Google. Воспользуйтесь 30-дневной бесплатной пробной версией и посмотрите, чего вы можете достичь:

Начать мою бесплатную пробную версию

Технический синтаксис robots.txt

Синтаксис robots.txt можно рассматривать как «язык» файлов robots.txt . Есть пять общих терминов, которые вы, вероятно, встретите в файле robots. Среди них:

Среди них:

Агент пользователя: Конкретный поисковый робот, которому вы даете инструкции по сканированию (обычно это поисковая система). Список большинства пользовательских агентов можно найти здесь.

Disallow: Команда, используемая для указания агенту пользователя не сканировать определенный URL-адрес. Для каждого URL разрешена только одна строка «Запретить:».

Разрешить (применимо только для робота Googlebot): команда, сообщающая роботу Googlebot, что он может получить доступ к странице или вложенной папке, даже если ее родительская страница или вложенная папка могут быть запрещены.

Crawl-delay: Сколько секунд сканер должен ждать перед загрузкой и сканированием содержимого страницы. Обратите внимание, что Googlebot не подтверждает эту команду, но скорость сканирования можно установить в Google Search Console.

Карта сайта: Используется для вызова местоположения любой карты сайта XML, связанной с этим URL-адресом.

Обратите внимание, что эта команда поддерживается только Google, Ask, Bing и Yahoo.

Обратите внимание, что эта команда поддерживается только Google, Ask, Bing и Yahoo.

Сопоставление с шаблоном

Когда дело доходит до фактических URL-адресов для блокировки или разрешения, файлы robots.txt могут быть довольно сложными, поскольку они позволяют использовать сопоставление с шаблоном для охвата диапазона возможных параметров URL. Google и Bing поддерживают два регулярных выражения, которые можно использовать для идентификации страниц или подпапок, которые SEO хочет исключить. Этими двумя символами являются звездочка (*) и знак доллара ($).

- * – это подстановочный знак, представляющий любую последовательность символов.

- $ соответствует концу URL-адреса.

Куда идет файл robots.txt на сайте?

Всякий раз, когда они заходят на сайт, поисковые системы и другие поисковые роботы (например, поисковый робот Facebook, Facebot) знают, что нужно искать файл robots.txt. Но они будут искать этот файл только в одном конкретном месте : в основном каталоге (обычно это ваш корневой домен или домашняя страница).

Если пользовательский агент посещает www.example.com/robots.txt и не находит там файл robots, он предполагает, что на сайте его нет, и продолжает сканировать все на странице (и, возможно, даже на всем сайте). Даже если страница robots.txt существует по адресу , скажем, example.com/index/robots.txt или www.example.com/homepage/robots.txt, она не будет обнаружена пользовательскими агентами, и, следовательно, сайт будет рассматриваться так, как если бы у него вообще не было файла robots.

Если пользовательский агент посещает www.example.com/robots.txt и не находит там файл robots, он предполагает, что на сайте его нет, и продолжает сканировать все на странице (и, возможно, даже на всем сайте). Даже если страница robots.txt существует по адресу , скажем, example.com/index/robots.txt или www.example.com/homepage/robots.txt, она не будет обнаружена пользовательскими агентами, и, следовательно, сайт будет рассматриваться так, как если бы у него вообще не было файла robots.Чтобы ваш файл robots.txt был найден, всегда включайте его в свой основной каталог или корневой домен.

Зачем вам robots.txt?

Файлы robots.txt контролируют доступ поисковых роботов к определенным областям вашего сайта. Хотя это может быть очень опасно, если вы случайно запретите роботу Googlebot сканировать весь ваш сайт (!!), в некоторых ситуациях файл robots.txt может оказаться очень полезным.

Некоторые распространенные варианты использования включают:

- Предотвращение дублирования контента в поисковой выдаче (обратите внимание, что метароботы часто являются лучшим выбором для этого)

- Сохранение конфиденциальности целых разделов веб-сайта (например, промежуточного сайта вашей инженерной группы)

- Предотвращение отображения страниц результатов внутреннего поиска в общедоступной поисковой выдаче

- Указание местоположения карт сайта (карт)

- Предотвращение индексации поисковыми системами определенные файлы на вашем веб-сайте (изображения, PDF-файлы и т.

д.)

д.) - Указание задержки сканирования, чтобы предотвратить перегрузку ваших серверов, когда сканеры загружают несколько фрагментов контента одновременно

Если на вашем сайте нет областей, к которым вы хотите контролировать доступ агента пользователя, возможно, вам вообще не нужен файл robots.txt.

Проверка наличия файла robots.txt

Не уверены, есть ли у вас файл robots.txt? Просто введите свой корневой домен, а затем добавьте /robots.txt в конец URL-адреса. Например, файл robots Moz находится по адресу moz.com/robots.txt.

Если страница .txt не отображается, у вас в настоящее время нет (действующей) страницы robots.txt.

Как создать файл robots.txt

Если вы обнаружили, что у вас нет файла robots.txt или вы хотите изменить свой, создать его несложно. В этой статье от Google рассматривается процесс создания файла robots.txt, и этот инструмент позволяет вам проверить, правильно ли настроен ваш файл.

Хотите попрактиковаться в создании файлов robots? В этом сообщении блога рассматриваются некоторые интерактивные примеры.

Передовой опыт SEO

Убедитесь, что вы не блокируете содержимое или разделы своего веб-сайта, которые хотите просканировать.

Ссылки на страницы, заблокированные robots.txt, не будут переходить. Это означает 1.) Если на них также не ссылаются другие страницы, доступные для поисковых систем (т. е. страницы, не заблокированные с помощью robots.txt, мета-роботов или иным образом), связанные ресурсы не будут сканироваться и не могут быть проиндексированы. 2.) Никакой вес ссылок не может быть передан с заблокированной страницы на место назначения ссылки. Если у вас есть страницы, на которые вы хотите передать право собственности, используйте другой механизм блокировки, отличный от robots.txt.

Не используйте robots.txt, чтобы предотвратить появление конфиденциальных данных (например, личной информации пользователя) в результатах поисковой выдачи. Поскольку другие страницы могут напрямую ссылаться на страницу, содержащую личную информацию (таким образом, в обход директив robots.

txt на вашем корневом домене или домашней странице), она все равно может быть проиндексирована. Если вы хотите заблокировать свою страницу в результатах поиска, используйте другой метод, например защиту паролем или мета-директиву noindex.

txt на вашем корневом домене или домашней странице), она все равно может быть проиндексирована. Если вы хотите заблокировать свою страницу в результатах поиска, используйте другой метод, например защиту паролем или мета-директиву noindex.Некоторые поисковые системы имеют несколько пользовательских агентов. Например, Google использует Googlebot для обычного поиска и Googlebot-Image для поиска изображений. Большинство пользовательских агентов из одной и той же поисковой системы следуют одним и тем же правилам, поэтому нет необходимости указывать директивы для каждого из нескольких сканеров поисковой системы, но возможность сделать это позволяет вам точно настроить сканирование содержимого вашего сайта.

Поисковая система кэширует содержимое robots.txt, но обычно обновляет кэшированное содержимое не реже одного раза в день. Если вы изменили файл и хотите обновить его быстрее, чем это происходит, вы можете отправить URL-адрес robots.txt в Google.

Robots.

..

.. Зп від 15000грн

Зп від 15000грн

..

.. ..

.. ..

..

com – робота для викладачів

com – робота для викладачів

Обратите внимание, что эта команда поддерживается только Google, Ask, Bing и Yahoo.

Обратите внимание, что эта команда поддерживается только Google, Ask, Bing и Yahoo. Если пользовательский агент посещает www.example.com/robots.txt и не находит там файл robots, он предполагает, что на сайте его нет, и продолжает сканировать все на странице (и, возможно, даже на всем сайте). Даже если страница robots.txt существует по адресу , скажем, example.com/index/robots.txt или www.example.com/homepage/robots.txt, она не будет обнаружена пользовательскими агентами, и, следовательно, сайт будет рассматриваться так, как если бы у него вообще не было файла robots.

Если пользовательский агент посещает www.example.com/robots.txt и не находит там файл robots, он предполагает, что на сайте его нет, и продолжает сканировать все на странице (и, возможно, даже на всем сайте). Даже если страница robots.txt существует по адресу , скажем, example.com/index/robots.txt или www.example.com/homepage/robots.txt, она не будет обнаружена пользовательскими агентами, и, следовательно, сайт будет рассматриваться так, как если бы у него вообще не было файла robots. д.)

д.)

txt на вашем корневом домене или домашней странице), она все равно может быть проиндексирована. Если вы хотите заблокировать свою страницу в результатах поиска, используйте другой метод, например защиту паролем или мета-директиву noindex.

txt на вашем корневом домене или домашней странице), она все равно может быть проиндексирована. Если вы хотите заблокировать свою страницу в результатах поиска, используйте другой метод, например защиту паролем или мета-директиву noindex.