Небольшая подборка материалов на тему “Формула Шеннона” (10 класс, профиль)

Самостоятельная работа ______________________________(Фамилия)

В-1.

Заполнить таблицу (вычисления обязательны)

Двоичная

Пятеричная

Десятеричная

Двенадцатеричная

10011001

10234

1764

1АВ1

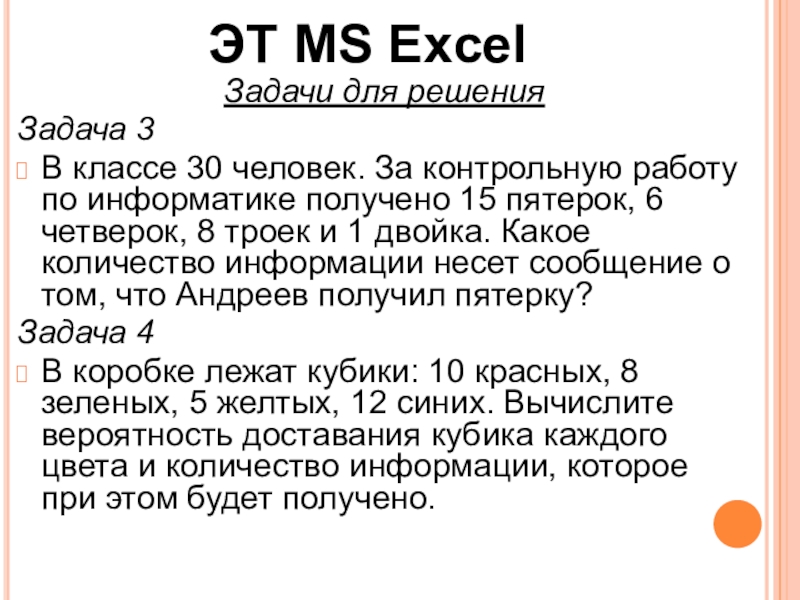

Решить задачу в ЭТ и заполнить таблицу:

Мама раздала детям разные фрукты: яблоки, груши, апельсины, мандарины, киви. Известно, что яблок было 15, мандаринов – 10, груш – 20, апельсинов – 10, а киви – 6 штук. Сколько информации содержит сообщение о том, что кто-то получил яблоко? Сколько информации содержится в сообщении о том, что ребенок получил какой-то фрукт? Ответы дать с точностью до двух знаков после запятой.

Событие

Кол-во, шт.

Вероятность события

Информация о событии

Вероятность события вообще

Самостоятельная работа______________________________(Фамилия)

В-2.

Заполнить таблицу (вычисления обязательны)

Двоичная

Пятеричная

Десятеричная

Двенадцатеричная

10101001

11034

1591

А1В1

Решить задачу в ЭТ и заполнить таблицу:

Учитель проводит контрольную работу по вариантам, разделенным по сложности: 1, 2 – простые, 3 – средней сложности, 4,5 – сложные. Известно, что карточек с 1 вариантом было 7, со вторым – 10, с третьим – 8, с четвертым – 5, а с пятым – 2 штуки. Сколько информации содержит сообщение о том, что кто-то получил 2 вариант? Сколько информации содержится в сообщении о том, что ученик получил какой-то вариант? Ответы дать с точностью до двух знаков после запятой.

Событие

Кол-во, шт.

Вероятность события

Информация о событии

Вероятность события вообще

Самостоятельная работа ______________________________(Фамилия)

В-3.

Заполнить таблицу (вычисления обязательны)

Двоичная

Пятеричная

Десятеричная

Двенадцатеричная

10111101

12304

2049

ААВ9

Решить задачу в ЭТ и заполнить таблицу:

В олимпиаде по химии принимают участие дети из 5 учебных заведений: школа № 1, школа № 3, школа № 5, школа № 7, школа № 9. Известно, что учеников из школы № 1 было 5, из школы № 3 – 2, из школы № 7 – 3, из школы № 5 – 1, а из школы № 9 – 6 человек. Сколько информации содержит сообщение о том, что выиграл ученик из школы № 9? Сколько информации содержится в сообщении о том, что кто-то выиграл олимпиаду? Ответы дать с точностью до двух знаков после запятой.

Событие

Кол-во, шт.

Вероятность события

Информация о событии

Вероятность события вообще

Самостоятельная работа______________________________(Фамилия)

В-4.

Заполнить таблицу (вычисления обязательны)

Двоичная

Пятеричная

Десятеричная

Двенадцатеричная

10101111

12234

2047

АВАВ

Решить задачу в ЭТ и заполнить таблицу:

В аквариуме плавает пять видов рыб: скалярии, барбусы, гурами, гуппи и неоны. Известно, что барбусов 7 рыб, скалярий – 2, гурами – 4, гуппи – 15, а неонов – 10 штук. Сколько информации содержит сообщение о том, что заболел один из гуппи? Сколько информации содержится в сообщении о том, что заболела одна рыбка? Ответы дать с точностью до двух знаков после запятой.

Событие

Кол-во, шт.

Вероятность события

Информация о событии

Вероятность события вообще

Ответы к заданиям самостоятельной работы.

В-4

2

5

10

12

10101111

1200

175

127

1110110000

12234

944

668

11111111111

2047

1227

100101000110011

1101440

18995

АВАВ

Событие

Кол-во

Вероятность

Информ о событ

Компон Шеннон

Скалярии

2

0,05

4,25

0,22

Гурами

4

0,11

3,25

0,34

Гуппи

15

0,39

1,34

0,53

Неоны

0,26

1,93

0,51

Барбусы

7

0,18

2,44

0,45

38

1,00

2,05

В-3

2

5

10

12

10111101

1224

189

139

1110111010

12304

676

100000000001

31144

2049

1229

100100110101101

1100421

18861

ААВ9

Событие

Кол-во

Вероятность

Информ о событ

Компон Шеннон

Школа 1

5

0,29

1,77

0,52

Школа 3

2

0,12

3,09

0,36

Школа 5

1

4,09

0,24

Школа 7

3

0,18

2,50

0,44

Школа 9

6

0,35

1,50

0,53

17

1,00

2,09

В-2

2

5

10

12

10101001

1134

169

121

1100000001

11034

769

541

11000110111

22331

1591

В07

100010010010101

1030212

17557

А1В1

Событие

Кол-во

Вероятность

Информ о событ

Компон Шеннон

1

7

0,22

2,19

0,48

2

10

0,31

1,68

0,52

8

0,25

2,00

0,50

4

5

0,16

2,68

0,42

5

2

0,06

4,00

0,25

32

1,00

2,17

В-1

2

5

10

12

10011001

1103

153

109

1010110110

10234

694

49А

11011100100

24024

1764

1030

110011100101

101201

3301

1АВ1

Событие

Кол-во

Вероятность

Информ о событ

Компон Шеннон

Груши

20

0,33

1,61

0,53

Яблоки

15

0,25

2,02

0,50

Апельсины

10

0,16

2,61

0,43

Мандарины

10

0,16

2,61

0,43

Киви

6

0,10

3,35

0,33

61

1,00

2,21

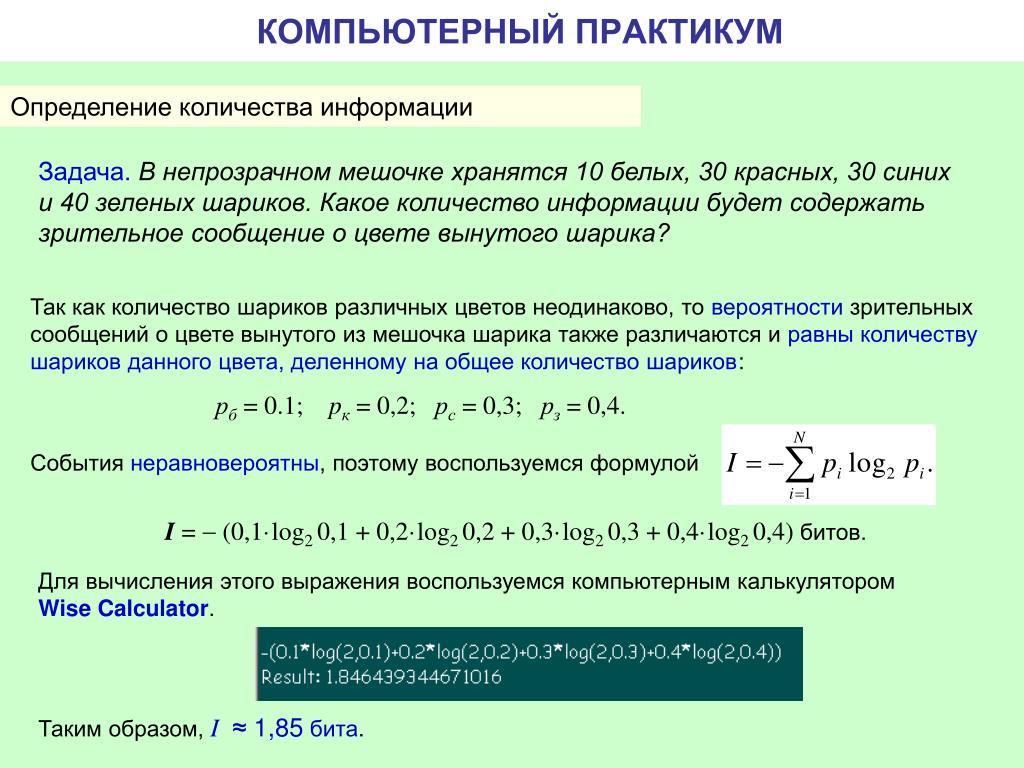

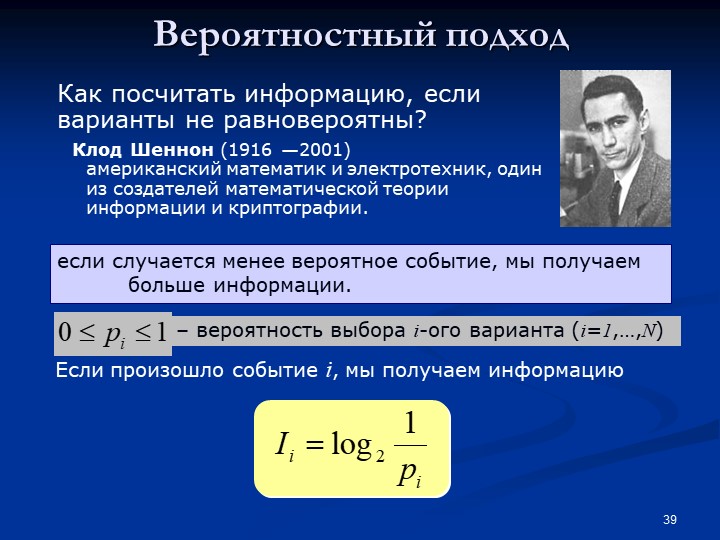

Вероятностный подход к определению количества информации.

Формула Шеннона. Решение задач

Формула Шеннона. Решение задачЦель урока:

1. Ввести формулу Шеннона для не равновероятных событий.

Ход уроков:

1. Организационный момент – сбор ИДЗ, объявление темы и целей урока – 5 мин;

2. Актуализация знаний учащихся – 10 мин;

3. Объяснение нового материала – 10 мин;

4. Решение задач – (20+25) мин;

5. Постановка домашнего задания – 3 мин;

6. Подведение итогов урока – 17 мин.

Актуализация знаний учащихся

На этом этапе предлагается обсудить (проверить владение материалом) следующие вопросы, а также поставить учащихся перед затруднением (задание 5, 6):

1. Приведите примеры равновероятных (В коробке 12 карандашей разного цвета) и неравновероятных (На ферме 12 цыплят, 7 кур, 1 петух и 5 гусей) событий?

2. Как определить вероятность выполнения определенного события? (Нужно количество событий определенного типа разделить на общее количество событий.)

3. Запишите (на доске) определение и два свойства логарифмов.

Запишите (на доске) определение и два свойства логарифмов.

(Опр-е: ,

Свойства: 1) ,

2) .)

4. На ферме живут 16 цыплят, 7 кур, 1 петух и 5 гусей. Определить количество информации в зрительном сообщении: «На рождество зажарили цыпленка». (I=4 бита)

5. Мама попросила дочку сходить в магазин и купить фрукты. В магазине в наличии было 4 кг. яблок, 5 кг. груш и 10 кг. апельсинов. Определить количество информации, полученной мамой в зрительном сообщении о покупке, сделанной дочкой.

Объяснение нового материала

В задаче 5 не конкретизировано, какие фрукты купила дочка. Информацией для мамы будет именно вид фруктов.

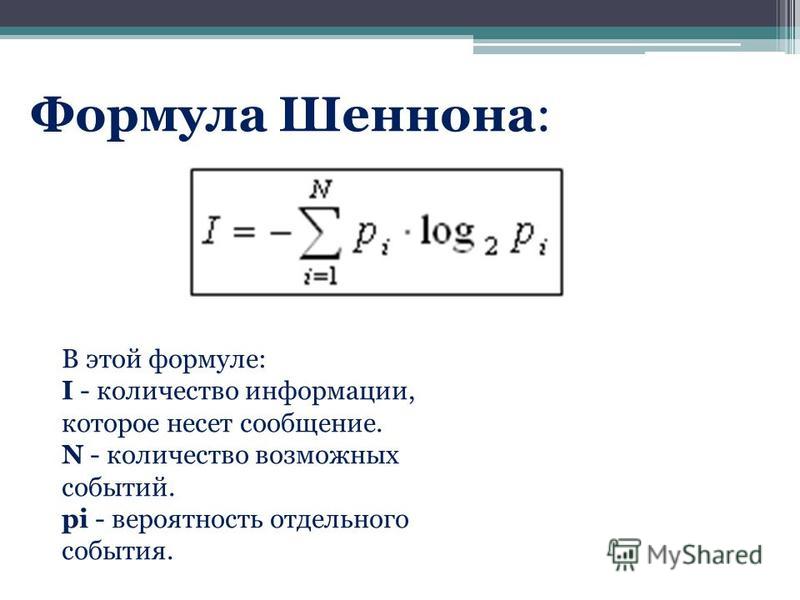

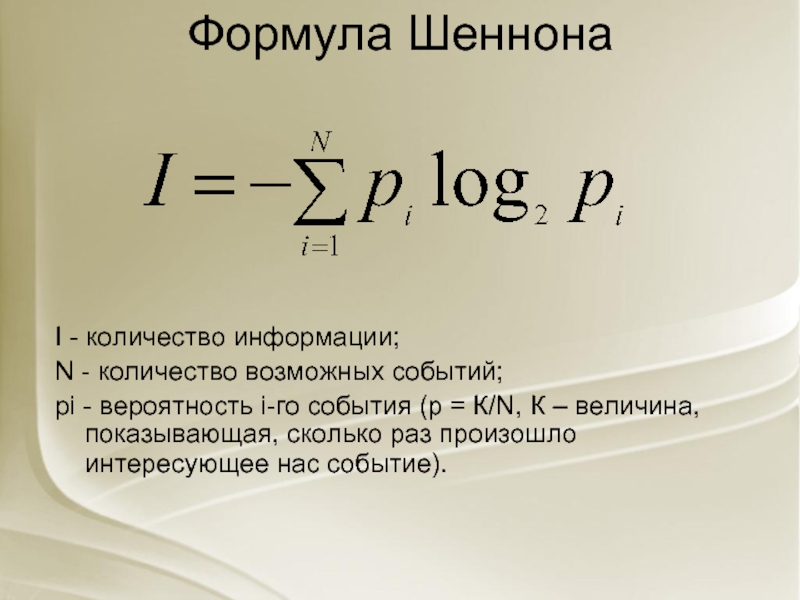

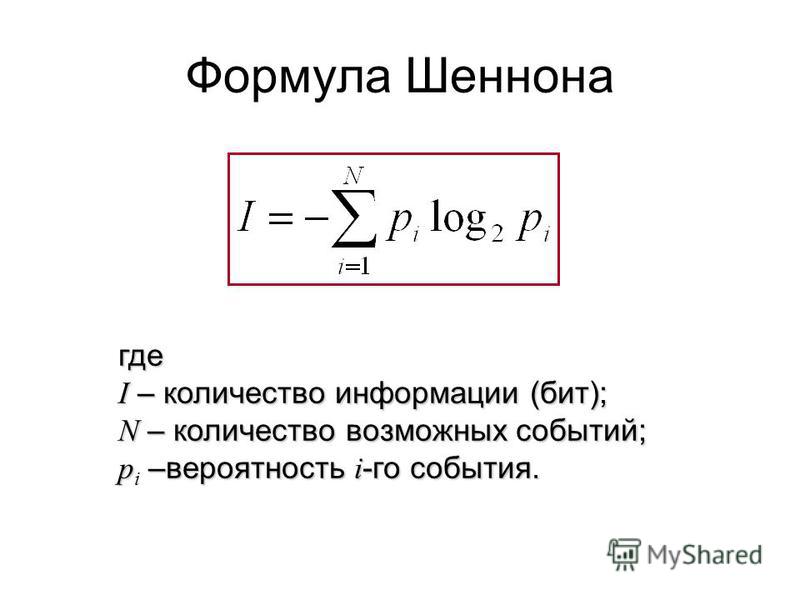

В 1948 году К. Шеннон предложил формулу для вычисления количества информации для неравновероятных событий в общем случае: , где I – количество информации, которое мы получим после реализации одного из возможных событий; N – количество видов возможных событий; Рi- вероятность i–го события.

Решим задачу 5.

Количество видов событий: N показывает сколько будет слагаемых. Речь идет о яблоках, грушах и апельсинах, поэтому N=3.

Определим вероятности покупки каждого вида фруктов: .

Тогда количество информации, которое получит мама после прихода дочки домой, можно рассчитать по формуле Шеннона:

Бита.

Решение задач (Тексты задач перед учащимися имеются, поэтому существует возможность для самостоятельного решения – 27 мин).

Задача №10. Вероятность первого события составляет 0,5, а второго и третьего — 0,25. Какое количество информации мы получим после реализации одного из них?

Решение.

Р1=0,5; Р2=Р3=0,25 Þ Бита.

Ответ: 1,5 бита.

Задача №11. За контрольную работу по информатике получено 8 пятерок, 13 четверок, 6 троек и 2 двойки. Какое количество информации получил Васечкин при получении тетради с оценкой?

Решение.

Краткая запись условия | Решение |

К5=8 К4=13 К3=6 К2=2 | Основная формула: , рк=. , , , Подставляем полученные вероятности: |

I – ? |

Ответ: 1,77 бита.

Задача №12. Известно, что в ящике лежат 20 шаров. Из них 10 — черных, 4 — белых, 4 — желтых и 2 — красный. Какое количество информации несёт сообщения о цвете вынутого шара?

Задача №13. Добрый экзаменатор никогда не ставит двоек по информатике. По причине своей доброты он заранее определил количество отметок каждого вида и произвольно расставил их абитуриентам. Количество информации, содержащееся в сообщении “Абитуриент Иванов не сдал экзамен на отлично”, равно 3-log27 бит. Информационный объем сообщения “Абитуриент Сидоров получил четверку” равен двум битам. Определите информационный объем зрительного сообщения о полученной оценки абитуриентом Сидоровым.

Решение. Из условия видно, что количество оценок, распределенных экзаменатором различное и вопрос задачи указывает на одну из всех возможных оценок, поэтому воспользуемся подходом к определению количества информации для неравновероятных событий, а именно формулой Шеннона.

Обозначим i4 – количество информации в сообщении “Абитуриент Сидоров получил четверку”, i4или3 – количество информации в сообщении “Абитуриент Иванов не сдал экзамен на отлично”, I – информационный объем зрительного сообщения о полученной оценки абитуриентом Сидоровым, К – показатель определенной оценки, р3, р4, р5 – вероятности выставления троек, четверок и пятерок соответственно, р4или3 – вероятность выставления оценки не отлично

Краткая запись условия | Решение |

I4или3=3-log27 бита I4=2 бита | Основные формулы: ,, Рк=, (*). Найдем вероятности р5 и р4: 3-log27=ÞÞ Þ, Аналогично Þ. Подставляем полученные вероятности в формулу (*) |

I – ? |

Ответ: 1,3 бита.

Задача №14. У скупого рыцаря в сундуке золотые, серебряные и медные монеты. Каждый вечер он извлекает из сундука одну из монет, любуется ею, и кладет обратно в сундук. Информационный объем сообщения “Из сундука извлечена золотая монета” равен трем битам. Количество информации, содержащееся в сообщении “Из сундука извлечена серебряная монета”, равно двум битам. Определите информационный объем зрительного сообщения о достоинстве вынутой монеты.

Каждый вечер он извлекает из сундука одну из монет, любуется ею, и кладет обратно в сундук. Информационный объем сообщения “Из сундука извлечена золотая монета” равен трем битам. Количество информации, содержащееся в сообщении “Из сундука извлечена серебряная монета”, равно двум битам. Определите информационный объем зрительного сообщения о достоинстве вынутой монеты.

Задача №15. В сейфе банкира Богатеева лежат банкноты достоинством 1, 10 или 100 талеров каждая. Банкир раскрыл свой сейф и наугад вытащил из него одну банкноту. Информационный объем сообщения “Из сейфа взята банкнота достоинством в 10 талеров” равен 3 бита. Количество информации, содержащееся в сообщении “Из сейфа взята банкнота достоинством не в 100 талеров”, равно 3-log25 бит. Определите информационный объем зрительного сообщения о достоинстве вынутой банкноты.

Домашнее задание (На этом этапе выдается задание на дом с пояснением его выполнения – 3 мин).

1. Выучить теорию – § 2.4 [8];

2. Решить задачи №123 (уровень оценки «3»), №124 (уровень оценки «4») и № 127, №128 (уровень оценки «5») [2].

Решить задачи №123 (уровень оценки «3»), №124 (уровень оценки «4») и № 127, №128 (уровень оценки «5») [2].

3. Подготовиться к контрольной работе (повторить §2.1-2.4 [8]).

Подведение итогов урока – на этом этапе полезно:

I. Вывод:

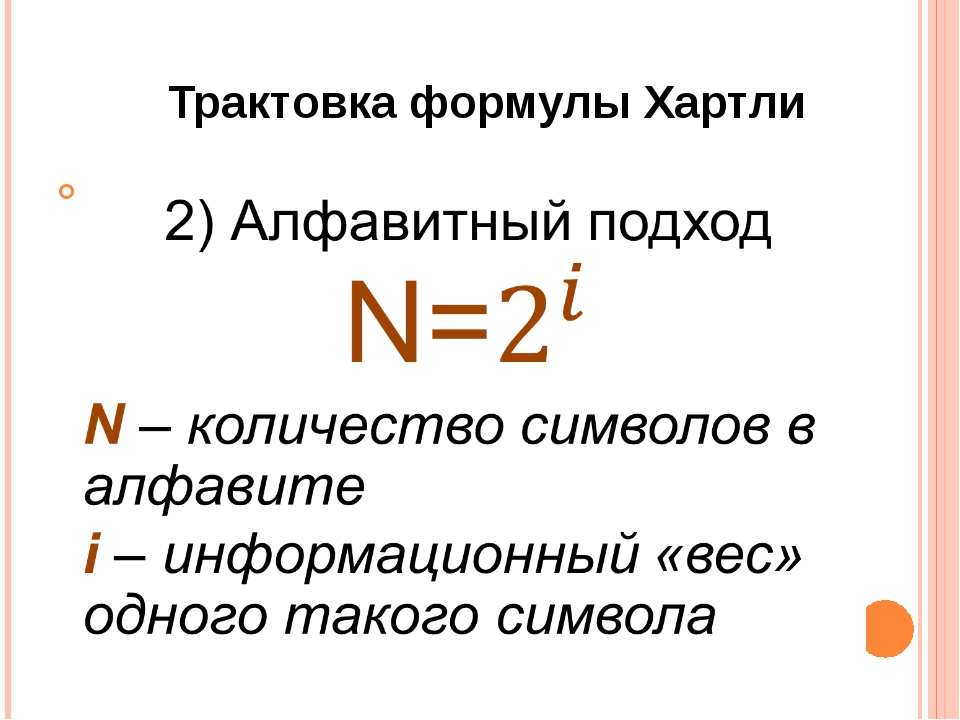

Как найти количество информации при совершении не равновероятных событий в общем и частном случаях? (Частный случай – формула Хартли – , общий случай – формула Шеннона – )

II. Самостоятельная работа (учащимся предлагается самостоятельно (без решения у доски) испробовать свои силы в различении подходов к определению информации и применению соответствующей формулы – 10 мин).

Вычисление количества информации. Решение задач

Решение задачна вычисление количества информации

Для решения различных задач на определение количества информации вы должны

помнить следующее:

отношение количества вариантов (или чисел) N к количеству информации которую

несет в себе один из вариантов I: N=2I

полный информационный объем сообщения V равен количество символов в

сообщении K умноженное на количество информации на каждый символ I: V=K*I.

Формула Шеннона для равновероятных событий: I=log2N.

если алфавит имеет мощность ( количество символов в этом алфавите) М, то количество всех

возможных «слов» (символьных цепочек) длиной N (без учета смысла) равно K=MN; для

двоичного кодирования (мощность алфавита M –2 символа) получаем известную формулу: K=2N

1 байт = 8 бит

1 Кбайт = 210байт = 1024 байт

1 Мбайт = 210Кбайт = 1024 Кбайт

1 Гбайт = 210Мбайт = 1024 Мбайт

Задача №1.

Световое табло состоит из лампочек. Каждая лампочка может находиться в

одном из трех состояний («включено», «выключено» или «мигает»).

Какое наименьшее количество лампочек должно находиться на табло,

чтобы с его помощью можно было передать 18 различных сигналов?

1) 6

2) 5

3) 3

4)4

Решение задачи №1.

K=MN

В данной задаче мощность алфавита равна 3 («включено»,

«выключено» или «мигает»), следовательно: M=3.

Количество необходимых сигналов R=18.

Найти надо К.

Следовательно:

18=3N,

N=3.

Ответ: 3.

Задача №2.

Метеорологическая станция ведет наблюдение за влажностью воздуха. Результатом одного

измерения является целое число от 0 до 100 процентов, которое записывается при помощи минимально

возможного количества бит. Станция сделала 80 измерений.

Определите информационный объем результатов наблюдений.

1) 80 бит

2) 70 байт

3) 80 байт

4) 560 байт

Решение задачи №2.

Определим информационный объем одного измерения: количество возможных вариантов

равно 100 (т.к. результатом одного измерения является целое число от 0 до100 процентов).

Следовательно, информационный объем одного варианта измерения находится по формуле:

N=2I

100=2I, I = 7 бит.

Так как станция сделала 80 измерений, следовательно, информационный объем результатов

наблюдений равен:

7*80=560 бит

Такого ответа нет, переведем биты в байты:

560 : 8=70 байт.

Ответ: 2.

Задача №3.

Сколько существует различных последовательностей из символов «плюс» и

«минус», длиной ровно в пять символов?

1) 64

2) 50

3) 32

4)20

Решение задачи №3.

K=MN

Мощность алфавита М – равна 2. Длина слова N – равна 5.

Количество различных последовательностей:

К=25,

К=32.

Ответ: 3.

Задача №4.

В корзине лежат 8 черных шаров и 24 белых шара.

Сколько бит информации несет сообщение о том, что достали черный шар?

1) 2 бита

2) 4 бита

3) 8 бит

4) 24бита

Решение задачи №4.

Черные шарики составляют 8/4 – 1/4 из всех шаров, следовательно информация о том что

достали черный шарик соответствует одному из 4 вариантов.

N=2I

1 из 4 вариантов несет в себе количество информации I – равное 2:

4=22.

Также можно решить данную задачу по формуле Шеннона: количество вариантов получения

черного шарика равна 4, следовательно, I=log24 = 2 бита.

Ответ: 2 бита.

Задача №5.

В коробке лежат 64 цветных карандаша.

Сообщение о том, что достали белый карандаш,

Сообщение о том, что достали белый карандаш,несет 4 бита информации.

Сколько белых карандашей было в коробке?

1) 4

2) 8

3) 16

4)32

Решение задачи №5.

Данная задача похожа на задачу № 4, только нам надо определить количество карандашей по

известному количеству информации который несет один карандаш.

Определим количество возможных событий (вариантов получения белого карандаша) по формуле

Шеннона:

log2N=4,

следовательно,

N=16.

Количество возможных событий получения белого карандаша равно 16, следовательно, количество

белых карандашей составляет 1/16 всех карандашей.

Всего карандашей 64, следовательно белых карандашей

64/16=4.

Ответ: 4 белых карандаша.

Задача № 6.

В некоторой стране автомобильный номер длиной 5 символов составляется из заглавных

букв (всего используется 30 букв) и десятичных цифр в любом порядке. Каждый символ кодируется

одинаковым и минимально возможным количеством бит, а каждый номер – одинаковым и

минимально возможным количеством байт.

Определите объем памяти, необходимый для хранения 50 автомобильных номеров.

1) 100 байт

2) 150 байт

3) 200 байт

4)250 байт

Решение задачи № 6.

Количество символов используемых для кодирования номера составляет: 30 букв + 10 цифр = 40

символов. Количество информации несущий один символ равен 6 бит (2I=40, но количество информации

не может быть дробным числом, поэтому берем ближайшую степень двойки большую количества

символов 26=64).

Мы нашли количество информации заложенное в каждом символе, количество символов в

номере равно 5, следовательно 5*6=30 бит. Каждый номер равен 30 битам информации, но по условию

задачи каждый номер кодируется одинаковым и минимально возможным количеством байт,

следовательно нам необходимо узнать сколько байт в 30 битах. Если разделить 30 на 8 получится дробное

число, а нам необходимо найти целое количество байт на каждый номер, поэтому находим ближайший

множитель 8-ки который превысит количество бит, это 4 (8*4=32).

Каждый номер кодируется 4 байтами.

Каждый номер кодируется 4 байтами.Для хранения 50 автомобильных номеров потребуется: 4*50=200 байт.

Ответ: 200 байт.

Задача № 7.

Для регистрации на сайте некоторой страны пользователю необходимо придумать пароль

длиной ровно 11 символов. В пароле можно использовать десятичные цифры и 12 различных

символов местного алфавита, причем все буквы используются в двух начертаниях – строчные и

прописные. Каждый символ кодируется одинаковым и минимально возможным количеством бит, а

каждый пароль – одинаковым и минимально возможным количеством байт.

Определите объем памяти, необходимый для хранения 60 паролей.

1) 720 байт

2) 660 байт

3) 540 байт

4)600 байт

Решение задачи № 7.

Количество символов используемых для кодирования пароля составляет: 10 цифр + 12

строчных букв + 12 прописных букв = 34 символа. Количество информации несущий один символ равен

6 бит (2I=34, но количество информации не может быть дробным числом, поэтому берем ближайшую

степень двойки большую количества символов 26=64).

Мы нашли количество информации заложенное в каждом символе, количество символов в

пароле равно 11, следовательно 11*6=66 бит. Каждый пароль равен 66 битам информации, но по условию

задачи каждый пароль кодируется одинаковым и минимально возможным количеством байт,

следовательно нам необходимо узнать сколько байт в 66 битах. Если разделить 66 на 8 получится

дробное число, а нам необходимо найти целое количество байт на каждый пароль, поэтому находим

ближайший множитель 8-ки который превысит количество бит, это 9 (8*9=72). Каждый номер

кодируется 9 байтами.

Для хранения 60 паролей потребуется: 9*60=540 байт.

Ответ: 540 байт.

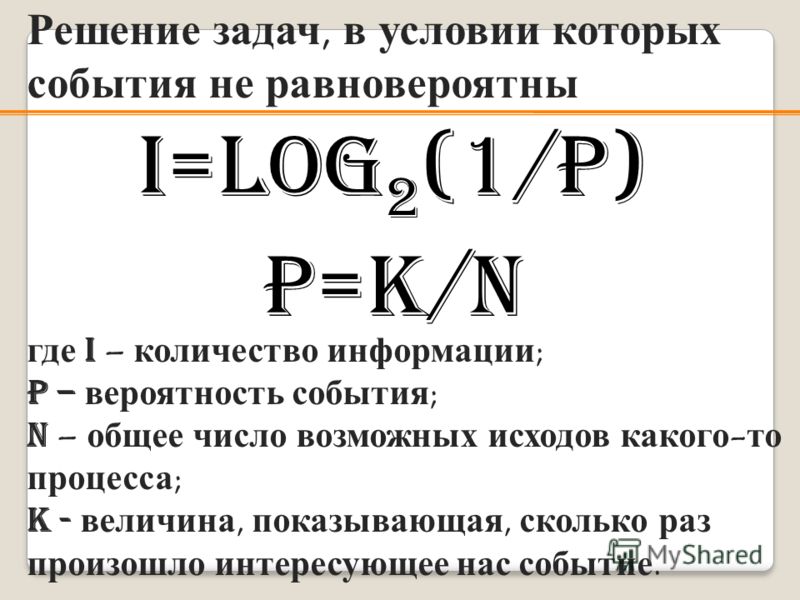

Измерение информации. Часть 3. Не равновероятные события. Решение задач.

В «Измерение информации. Часть 2» мы разбирали решение задач, в которых рассматривались равновероятные события (например: орел или решка — вероятность выпадения 50\50). Сегодня мы рассмотрим несколько задач на тему «Измерение количества информации при не равновероятностном подходе».

Задача 1.

В корзине лежат 8 черных шаров и 24 белых. Сколько информации несет сообщение о том, что достали черный шар?

Задача 2.

В коробке лежат 64 цветных карандаша. Сообщение о том, что достали белый карандаш, несет 4 бита информации. Сколько белых карандашей было в корзине?

Задача 3.

За четверть ученик получил 100 оценок. Сообщение о том, что он получил пятерку несет 2 бита информации. Сколько пятерок ученик получил за четверть?

Задача 4.

Для ремонта школы использовали красную, зеленую и коричневую краски. Израсходовали одинаковое количество банок красной, зеленой и коричневой краски. Сообщение о том, что закончилась банка красной краски несет 2 бита информации. Зеленой краски израсходовали 8 банок. Сколько банок коричневой краски израсходовали на ремонт школы?

Задача 5.

В коробке лежат белые и черные шары. Среди них 18 черных шаров. Сообщение о том, что из корзины достали белый шар, несет 2 бита информации. Сколько всего в корзине шаров?

Решение задач, в условии которых события не равновероятны

Формулы, которые необходимы для решения таких задач можно посмотреть на «Измерение информации. Часть 1»

Часть 1»

Мы имеем 2 формулы:

Формулы вероятности и формула Шеннона

Если применим преобразования и подставим переменную p из первой формулы во вторую, получим новую формулу, которая значительно упростит нам жизнь:

Новая формула

Решение задачи №1.

Kч = 8

Кб = 24

iб — ?

(индексы «б» и «ч» указывают на то, к каким шарика, белым или черным, относится данная переменная)

Воспользуемся выведенной формулой:

Формула

В данной формуле неизвестна переменная N — это общее число событий (или шариков). N=Kб + Кч = 8 +24 = 32 (шарика)

Получим, что iб = 2 (бита). (т.к. 22 = 4) (при решении можно использовать логарифм, если с ним знакомы).

Ответ: сообщение о том, что достали белый шарик, несет 2 бита информации.

Решение задачи №2

N = 64 карандаша

iб = 4 бита

Кб — ?

Воспользуемся той же выведенной формулой:

Формула

Подставив в нее известные величины, получим:

Решение задачи №2

Ответ: количество белых карандашей равно 4.

Решение задачи №3

N = 100

i5 = 2 бита

K5 — ?

Аналогично предыдущей задаче:

Решение задачи №3

Ответ: ученик получил 25 пятерок.

Решение задачи №4

Kк = Кз = Ккор

iк = 2 бита

Кз = 8 банок

Ккор — ?

Т.к. Kк = Кз = Ккор следует, что: количество красной краски равно 8 банок, количество зеленой краски — 8 банок и количество коричневой краски — 8 банок.

Зная, что Кк = 8, можем воспользоваться нашей выведенной формулой:

Решение задачи №4

Нашли общее число банок.

Чтобы найти количество коричневой краски необходимо из общего числа вычесть количество красной и зеленой краски.

Решение задачи №4

Ответ: количество коричневой краски — 16 банок

Решение задачи №5

Кч = 18

iб = 2 бита

N — ?

Пожалуйста, зарегистрируйтесь, чтобы увидеть скрытый текст

на Ваш сайт.

Количество информации. Формулы Хартли и Шеннона

В 1928 г. американский инженер Р. Хартли предложил научный подход к оценке сообщений. Предложенная им формула имела следующий вид:

I

= log2 K ,

Где К – количество равновероятных событий; I –

количество бит в сообщении, такое, что любое из К событий произошло.

Тогда K=2I.

Иногда формулу Хартли записывают так:

I

= log2 K = log2 (1 / р) = – log2 р,

т.

к. каждое из К событий имеет равновероятный исход р = 1 / К, то К = 1 / р.

Задача.

Шарик находится в одной из трех урн: А, В или С. Определить сколько бит информации содержит сообщение о том, что он находится в урне В.

Решение.

Такое сообщение содержит I = log2 3 =

1,585 бита информации.

Но не все ситуации имеют одинаковые вероятности реализации. Существует много таких ситуаций, у которых вероятности реализации различаются. Например, если бросают несимметричную монету или “правило бутерброда”.

“Однажды в детстве я уронил бутерброд. Глядя, как я виновато вытираю масляное пятно, оставшееся на полу, старший брат успокоил меня:

– не горюй, это сработал закон бутерброда.

– Что еще за закон такой? – спросил я.

– Закон, который гласит: “Бутерброд всегда падает маслом вниз”. Впрочем, это шутка, – продолжал брат.- Никакого закона нет. Прсто бутерброд действительно ведет себя довольно странно: большей частью масло оказывается внизу.

– Давай-ка еще пару раз уроним бутерброд, проверим, – предложил я. – Все равно ведь его придется выкидывать.

Проверили. Из десяти раз восемь бутерброд упал маслом

вниз.

И тут я задумался: а можно ли заранее узнать, как сейчас упадет бутерброд маслом вниз или вверх?

Наши опыты прервала мать…”

(

Отрывок из книги “Секрет великих полководцев”, В.Абчук).

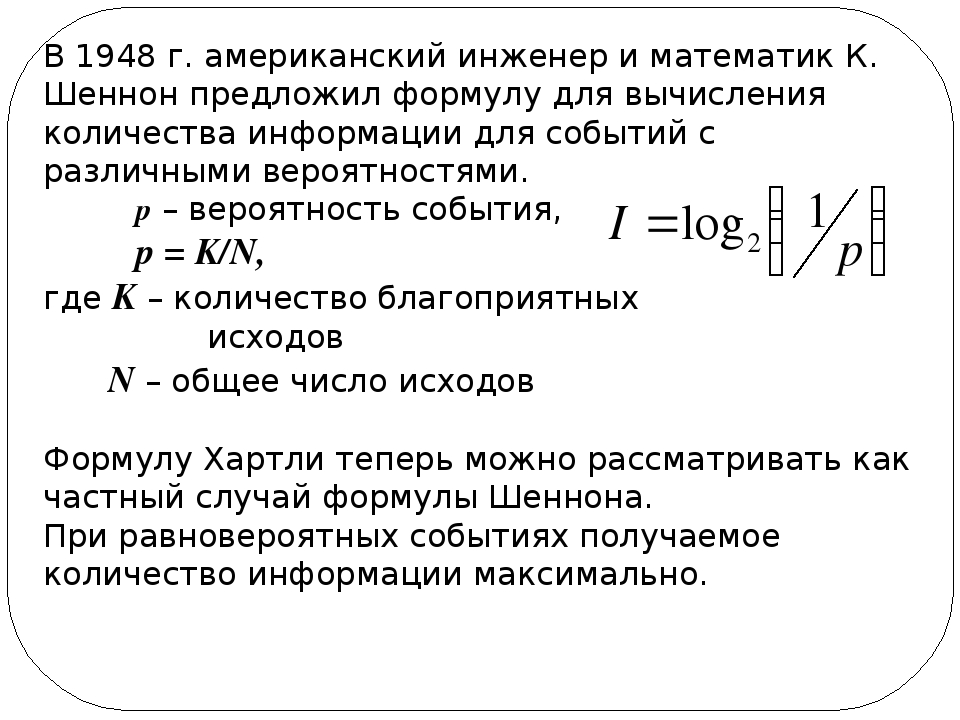

В 1948 г. американский инженер и математик К Шеннон

предложил формулу для вычисления количества информации для событий с

различными вероятностями.

Если I – количество

информации,

К –

количество возможных

событий,

рi –

вероятности отдельных событий,

то количество информации для событий с

различными вероятностями можно определить по формуле:

I

= – Sum рi log2 рi,

где i принимает

значения от 1 до К.

Формулу Хартли теперь можно рассматривать как частный случай формулы Шеннона:

I

= – Sum 1 / К log2 (1 / К) = I = log2 К.

При равновероятных событиях получаемое количество информации максимально.

Задачи.

1. Определить количество

информации, получаемое при реализации одного из событий, если

бросают

а) несимметричную четырехгранную пирамидку;

б) симметричную

и однородную четырехгранную пирамидку.

Решение.

а) Будем

бросать несимметричную четырехгранную пирамидку.

Вероятность отдельных

событий будет такова:

р1 = 1 / 2,

р2 = 1 / 4,

р3 = 1 / 8,

р4 =

1 / 8,

тогда количество информации, получаемой после реализации одного

из этих событий, рассчитывается по формуле:

I = -(1 / 2 log2 1/2 + 1 / 4 log2 1/4 + 1 / 8 log2 1/8 + 1 / 8

log2 1/8) = 1 / 2 + 2 / 4 + + 3 / 8 + 3 / 8 = 14/8 = 1,75

(бит).

б) Теперь рассчитаем количество информации, которое получится

при бросании симметричной и однородной четырехгранной пирамидки:

I =

log2 4 = 2 (бит).

2. Вероятность перового события составляет

0,5, а второго и третьего 0,25. Какое количество информации мы получим

после реализации одного из них?

3. Какое количество информации будет

получено при игре в рулетку с 32-мя секторами?

4. Сколько различных чисел можно закодировать с помощью 8 бит?

Решение: I=8 бит, K=2I=28=256 различных чисел.

Физиологи и психологи научились определять количество

информации, которое человек может воспринимать при помощи органов чувств,

удерживать в памяти и подвергать обработке. Информацию можно представлять

в различных формах: звуковой, знаковой и др. рассмотренный выше способ

определения количества информации, получаемое в сообщениях, которые

уменьшают неопределенность наших знаний, рассматривает информацию с

позиции ее содержания, новизны и понятности для человека. С этой точки

зрения в опыте по бросанию кубика одинаковое количество информации

содержится в сообщениях “два”, “вверх выпала грань, на которой две точки”

и в зрительном образе упавшего кубика.

При передаче и хранении информации с помощью различных технических устройств информацию следует рассматривать как последовательность знаков (цифр, букв, кодов цветов точек изображения), не рассматривая ее содержание.

Считая, что алфавит (набор символов знаковой системы) – это событие, то появление одного из символов в сообщении можно рассматривать как одно из состояний события. Если появление символов равновероятно, то можно рассчитать, сколько бит информации несет каждый символ. Информационная емкость знаков определяется их количеством в алфавите. Чем из большего количества символов состоит алфавит, тем большее количество информации несет один знак. Полное число символов алфавита принято называть мощностью алфавита.

Молекулы ДНК (дезоксирибонуклеиновой кислоты)

состоят из четырех различных составляющих (нуклеотидов), которые образуют

генетический алфавит. Информационная емкость знака этого алфавита

составляет:

Информационная емкость знака этого алфавита

составляет:

4 = 2I, т.е. I = 2 бит.

Каждая буква русского алфавита (если считать, что е=е) несет информацию 5 бит (32 = 2I).

При таком подходе в результате сообщения о результате бросания кубика , получим различное количество информации, Чтобы его подсчитать, нужно умножить количество символов на количество информации, которое несет один символ.

Количество информации, которое содержит сообщение, закодированное с помощью знаковой системы, равно количеству информации, которое несет один знак, умноженному на число знаков в сообщении.

Использованы материалы учителя информатики школы № 3Ильиной Ольги Владимировны, г. Тутаев Ярославской обл..

Практическое задание по теме «Создание и запись математических формул в OpenOffice.Math»

Цели работы:

- ознакомление с функциями и возможностями OpenOffice.

Math;

Math; - научиться создавать с OpenOffice.Math различные типы формул;

- развитие самостоятельности при выполнении заданий;

- показать взаимосвязь и межпредметные связи.

Оборудование:

Windows XP, сетевое окружение, расшаренная папка «Папка для студентов»,программа OpenOffice.Math, программа OpenOffice.Writer.

Этапы работы:

- Организационный момент. (2 мин)

- Проверка подготовки к занятию. (5 мин)

- Объяснение нового необходимого для выполнения задания материала. (15мин)

- Выполнение практической работы. ( 1 час 15 минут)

- Подведение итогов, оценка деятельности (5 мин)

- Постановка домашнего задания. (5 мин)

Вопросы для опроса:

- Что такое OpenOffice?

- В какой программе этого офисного пакета можно набирать и оформлять текст?

- Как вводить формулы?

- Можно ли по этой формуле вычислить конкретное значение?

Ход занятия:

Для успешного выполнения задания вам потребуется ознакомиться с языком разметки OOo Math.

Формулу можно ввести посимвольно, непосредственно в самом документе OpenOffice.Math.

Ввод формулы

Существует три способа ввести формулу:

- Выбрать символ из окна Выбор.

- Щелкнуть правой кнопкой мыши на редакторе формулы и выбрать символ из появившегося контекстного меню.

- Ввести разметку в редакторе формул.

Вставка формулы в OOo Writer

- Для вставки формулы в OOo Writer, выполните Вставить > Объект > Формула.

- Внизу экрана открывается Редактор формул, и появляется всплывающее окно Выбор. Вы будете также видеть маленький блок (с серой границей) в вашем документе, где будет отображаться формула.

- К примеру, введите в текстовый документ следующую формулу: a sup 2 + b sup 2 = c sup 2″. Выделите её, а затем выберите команду Вставить > Объект > Формула. Набранный текст будет преобразован в формулу.

Примеры языка разметки (см.

2)over (x+1) right) + ln(z)

2)over (x+1) right) + ln(z)Примеры сложных формул

Задание 3. Самостоятельное задание по вариантам

Список источников:

- Руководство по OpenOffice.org — 2006.

Интернет-ресурсы:

- MyOOo.ru: доступно и просто об OpenOffice.org. Объекты Math: редактор формул OpenOffice.org [Электронный ресурс] . – Режим доступа: http://myooo.ru/content/view/48/54/

Практическое задание по теме «Архивация данных» Практическое задание по теме «Задание на редактирование и замену в тексте при помощи редактора Microsoft Word»

17. Формула Хартли. Формула Шеннона.

Формула Хартли. Формула Шеннона. Теорема Шеннона-Хартли. Теорема Котельникова. ИКМ. Основной цифровой поток DS0

Формула Хартли

Формула Хартли определяет количество информации, содержащееся в сообщении длины n.

Имеется алфавит А, из букв которого составляется сообщение:

Количество возможных вариантов разных сообщений:

где N — возможное количество различных сообщений, шт; m — количество букв в алфавите, шт; n — количество букв в сообщении, шт.

Пример: Алфавит состоит из двух букв «B» и «X», длина сообщения 3 буквы — таким образом, m=2, n=3. При выбранных нами алфавите и длине сообщения можно составить разных сообщений «BBB», «BBX», «BXB», «BXX», «XBB», «XBX», «XXB», «XXX» — других вариантов нет.

Формула Хартли определяется:

где I — количество информации, бит.

При равновероятности символов формула Хартли переходит в собственную информацию.

Формула Хартли была предложена Ральфом Хартли в 1928 году как один из научных подходов к оценке сообщений.

Иллюстрация

Допустим, нам требуется что-либо найти или определить в той или иной системе. Есть такой способ поиска, как «деление пополам». Например, кто-то загадывает число от 1 до 100, а другой должен отгадать его, получая лишь ответы «да» или «нет». Задаётся вопрос: «число меньше N?». Любой из ответов «да» и «нет» сократит область поиска вдвое. Далее по той же схеме диапазон снова делится пополам. В конечном счёте загаданное число будет найдено.

В конечном счёте загаданное число будет найдено.

Сколько вопросов надо задать, чтобы найти задуманное число от 1 до 100. Допустим загаданное число 27. Вариант диалога:

Больше 50? Нет.

Больше 25? Да.

Больше 38? Нет.

Меньше 32? Да.

Меньше 29? Да.

Больше 27? Нет.

Это число 26? Нет.

Если число не 26 и не больше 27, то это явно 27. Чтобы угадать методом «деления пополам» число от 1 до 100, нам потребовалось 7 вопросов.

Можно просто спрашивать: это число 1? Это число 2? И т. д. Но тогда вам потребуется намного больше вопросов. «Деление пополам» — самый оптимальный способ нахождения числа. Объём информации, заложенный в ответ «да»/«нет», равен одному биту (действительно, ведь бит имеет два состояния: 1 или 0). Итак, для угадывания числа от 1 до 100 нам потребовалось семь бит (семь ответов «да»/«нет»).

Такой формулой можно представить, сколько вопросов (бит информации) потребуется, чтобы определить одно из возможных значений. N — это количество значений, а k — количество бит. Например, в нашем примере 100 меньше, чем 27, однако больше, чем 26. Да, нам могло бы потребоваться и всего 6 вопросов, если бы загаданное число было 28.

N — это количество значений, а k — количество бит. Например, в нашем примере 100 меньше, чем 27, однако больше, чем 26. Да, нам могло бы потребоваться и всего 6 вопросов, если бы загаданное число было 28.

Формула Хартли:.

Количество информации (k), необходимой для определения конкретного элемента, есть логарифм по основанию 2 общего количества элементов (N).

Формула Шеннона

Когда события не равновероятны, может использоваться формула Шеннона., где

Информацио́нная энтропи́я — мера неопределённости или непредсказуемости информации, неопределённость появления какого-либо символа первичного алфавита. При отсутствии информационных потерь численно равна количеству информации на символ передаваемого сообщения.

Например, в последовательности букв, составляющих какое-либо предложение на русском языке, разные буквы появляются с разной частотой, поэтому неопределённость появления для некоторых букв меньше, чем для других. Если же учесть, что некоторые сочетания букв (в этом случае говорят об энтропии -го порядка, см. ниже) встречаются очень редко, то неопределённость уменьшается еще сильнее.

Если же учесть, что некоторые сочетания букв (в этом случае говорят об энтропии -го порядка, см. ниже) встречаются очень редко, то неопределённость уменьшается еще сильнее.

Для иллюстрации понятия информационной энтропии можно также прибегнуть к примеру из области термодинамической энтропии, получившему название демона Максвелла. Концепции информации и энтропии имеют глубокие связи друг с другом, но, несмотря на это, разработка теорий в статистической механике и теории информации заняла много лет, чтобы сделать их соответствующими друг другу.

Энтропия — это количество информации, приходящейся на одно элементарное сообщение источника, вырабатывающего статистически независимые сообщения.

Формальные определения

Информационная двоичная энтропия для независимых случайных событий с возможными состояниями (от до , — функция вероятности) рассчитывается по формуле

Эта величина также называется средней энтропией сообщения. Величина называется частной энтропией, характеризующей только -e состояние.

Величина называется частной энтропией, характеризующей только -e состояние.

Таким образом, энтропия события является суммой с противоположным знаком всех относительных частот появления события , умноженных на их же двоичные логарифмы[1]. Это определение для дискретных случайных событий можно расширить для функции распределения вероятностей.

Определение по Шеннону

Клод Шеннон предположил, что прирост информации равен утраченной неопределённости, и задал требования к её измерению:

1. мера должна быть непрерывной; то есть изменение значения величины вероятности на малую величину должно вызывать малое результирующее изменение функции;

2. в случае, когда все варианты (буквы в приведённом примере) равновероятны, увеличение количества вариантов (букв) должно всегда увеличивать значение функции;

3. должна быть возможность сделать выбор (в нашем примере букв) в два шага, в которых значение функции конечного результата должно являться суммой функций промежуточных результатов.

Поэтому функция энтропии должна удовлетворять условиям

1. определена и непрерывна для всех , где для всех и . (Нетрудно видеть, что эта функция зависит только от распределения вероятностей, но не от алфавита.)

2. Для целых положительных , должно выполняться следующее неравенство:

3. Для целых положительных , где , должно выполняться равенство

Шеннон показал, что единственная функция, удовлетворяющая этим требованиям, имеет вид

где — константа (и в действительности нужна только для выбора единиц измерения).

Шеннон определил, что измерение энтропии (), применяемое к источнику информации, может определить требования к минимальной пропускной способности канала, требуемой для надёжной передачи информации в виде закодированных двоичных чисел. Для вывода формулы Шеннона необходимо вычислить математическое ожидание «количества информации», содержащегося в цифре из источника информации. Мера энтропии Шеннона выражает неуверенность реализации случайной переменной. Таким образом, энтропия является разницей между информацией, содержащейся в сообщении, и той частью информации, которая точно известна (или хорошо предсказуема) в сообщении. Примером этого является избыточность языка — имеются явные статистические закономерности в появлении букв, пар последовательных букв, троек и т. д. (см. цепи Маркова).

Мера энтропии Шеннона выражает неуверенность реализации случайной переменной. Таким образом, энтропия является разницей между информацией, содержащейся в сообщении, и той частью информации, которая точно известна (или хорошо предсказуема) в сообщении. Примером этого является избыточность языка — имеются явные статистические закономерности в появлении букв, пар последовательных букв, троек и т. д. (см. цепи Маркова).

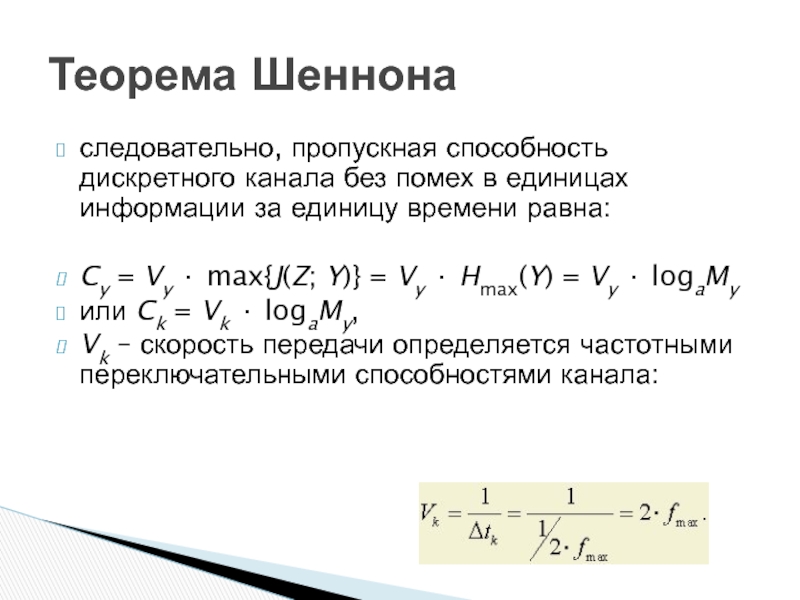

Теорема Шеннона — Хартли в теории информации — применение теоремы кодирования канала с шумом к архетипичному случаю непрерывного временно́го аналогового канала коммуникаций, искажённого гауссовским шумом. Теорема устанавливает шенноновскую ёмкость канала, верхнюю границу максимального количества безошибочных цифровых данных (то есть, информации), которое может быть передано по такой связи коммуникации с указанной полосой пропускания в присутствии шумового вмешательства, согласно предположению, что мощность сигнала ограничена, и гауссовский шум характеризуется известной мощностью или мощностью спектральной плотности. Закон назван в честь Клода Шеннона и Ральфа Хартли.

Закон назван в честь Клода Шеннона и Ральфа Хартли.

Рассматривая все возможные многоуровневые и многофазные методы шифрования, теорема Шеннона — Хартли утверждает, что пропускная способность канала , означающая теоретическую верхнюю границу скорости передачи данных, которые можно передать с данной средней мощностью сигнала через аналоговый канал связи, подверженный аддитивному белому гауссовскому шуму мощности равна:

где — пропускная способность канала, бит/с; — полоса пропускания канала, Гц; — полная мощность сигнала над полосой пропускания, Вт или В²; — полная шумовая мощность над полосой пропускания, Вт или В²; — частное от деления отношения сигнала к его шуму (SNR) на гауссовский шум, выраженное как отношение мощностей.

В данной теореме определено, что достичь максимальной скорости (бит/с) можно путем увеличения полосы пропускания и мощности сигнала и, в то же время, уменьшения шума.

Теорема Шеннона — Хартли ограничивает информационную скорость (бит/с) для заданной полосы пропускания и отношения «сигнал/шум». Для увеличения скорости необходимо увеличить уровень полезного сигнала, по отношению к уровню шума.

Для увеличения скорости необходимо увеличить уровень полезного сигнала, по отношению к уровню шума.

Если бы существовала бесконечная полоса пропускания, бесшумовой аналоговый канал, то можно было бы передать неограниченное количество безошибочных данных по ней за единицу времени. Реальные каналы имеют ограниченные размеры и в них всегда присутствует шум.

Удивительно, но не только ограничения полосы пропускания влияют на количество передаваемой информации. Если мы комбинируем шум и ограничения полосы пропускания, мы действительно видим, что есть предел количества информации, которую можно было передать, даже используя многоуровневые методы кодирования. В канале, который рассматривает теорема Шеннона — Хартли, шум и сигнал дополняют друг друга. Таким образом, приёмник воспринимает сигнал, который равен сумме сигналов, кодирующего нужную информацию и непрерывную случайную, которая представляет шум.

Это дополнение создает неуверенность относительно ценности оригинального сигнала. Если приёмник обладает информацией о вероятности ненужного сигнала, который создает шум, то можно восстановить информацию в оригинальном виде, рассматривая все возможные влияния шумового процесса. В случае теоремы Шеннона — Хартли шум, как таковой, произведен гауссовским процессом с некоторыми отклонениями в канале передачи. Такой канал называют совокупным белым гауссовским шумовым каналом, так как гауссовский шум является частью полезного сигнала. «Белый» подразумевает равное количество шума во всех частотах в пределах полосы пропускания канала. Такой шум может возникнуть при воздействии случайных источников энергии, а также быть связан с ошибками, возникшими при кодировании. Зная о вероятности возникновения гауссовского шума, значительно упрощается определение полезного сигнала.

Если приёмник обладает информацией о вероятности ненужного сигнала, который создает шум, то можно восстановить информацию в оригинальном виде, рассматривая все возможные влияния шумового процесса. В случае теоремы Шеннона — Хартли шум, как таковой, произведен гауссовским процессом с некоторыми отклонениями в канале передачи. Такой канал называют совокупным белым гауссовским шумовым каналом, так как гауссовский шум является частью полезного сигнала. «Белый» подразумевает равное количество шума во всех частотах в пределах полосы пропускания канала. Такой шум может возникнуть при воздействии случайных источников энергии, а также быть связан с ошибками, возникшими при кодировании. Зная о вероятности возникновения гауссовского шума, значительно упрощается определение полезного сигнала.

Сравнивая пропускную способность канала и формулу Хартли, мы можем найти эффективное число различимых уровней:

Взятие квадратного корня по сути возвращает отношение мощностей к отношению напряжений, таким образом число уровней приблизительно равно отношению среднеквадратичной амплитуды сигнала к шумовому стандартному отклонению. Это подобие в форме между пропускной способностью по Шеннону и формулой Хартли не стоит понимать буквально, что для безошибочной передачи достаточно уровней сигнала. Избыточное кодирование для устранения ошибок потребует большего числа уровней, но предельная скорость передачи данных, к которой можно приблизиться с кодированием, эквивалентна использованию того самого из формулы Хартли.

Это подобие в форме между пропускной способностью по Шеннону и формулой Хартли не стоит понимать буквально, что для безошибочной передачи достаточно уровней сигнала. Избыточное кодирование для устранения ошибок потребует большего числа уровней, но предельная скорость передачи данных, к которой можно приблизиться с кодированием, эквивалентна использованию того самого из формулы Хартли.

ИКМ

Передача квантованных значений сигнала с помощью коротких импульсов различной высоты называется амплитудно-импульсной модуляцией (АИМ). Под импульсно-кодовой модуляцией (ИКМ) понимается передача непрерывных функций при помощи двоичного кода.

При кодовой модуляции необходимо передать числа, выражающие величину квантованных отсчетов. Для этого можно воспользоваться двоичным кодом. Числа, подлежащие передаче, надо записать в двоичной системе счисления – это и даст необходимые кодовые комбинации. При помощи n – значных двоичных чисел можно представить чисел. Благодаря квантованию количество чисел, подлежащих передаче, сводится до конечной величины . Если принять шаг квантования за единицу, то будет означать наибольшее квантованное значение. Количество знаков в двоичной кодовой комбинации равно . Если n – не целое, то оно округляется до ближайшего целого числа. На рис. 3 показаны преобразования аналогового сигнала (а) в АИМ (б) и ИКМ (в) для n = 4.

Благодаря квантованию количество чисел, подлежащих передаче, сводится до конечной величины . Если принять шаг квантования за единицу, то будет означать наибольшее квантованное значение. Количество знаков в двоичной кодовой комбинации равно . Если n – не целое, то оно округляется до ближайшего целого числа. На рис. 3 показаны преобразования аналогового сигнала (а) в АИМ (б) и ИКМ (в) для n = 4.

Рис. 3

При выборе шага квантования (или числа) следует учитывать два фактора. С одной стороны, увеличение числа ступеней квантования увеличивает точность передачи сигнала, с другой – требует удлинения кодовой комбинации (n). Так для телефонной передачи установлено, что удовлетворительное качество передачи достигается при , т.е. при семизначном коде.

При анализе приема сигналов с импульсно-кодовой модуляцией обычно рассматривают не отношение средних мощностей сигнала и помехи, а отношение половины шага квантования (цена округления) к среднеквадратичному значению помехи . Квадрат отношения

заменяет отношение сигнал – шум.

Пусть число уровней квантования равно . Будем передавать каждое из значенийn-значным кодовым числом, составленным из импульсов, квантованных на m уровней (АИМ). Общее число возможных комбинаций равно . Очевидно, что . Пусть шкала уровней симметрична относительно нуля , т. е. разрешенными являются уровни :

Если все уровни равновероятны, средняя мощность сигнала равна

Отсюда шаг квантования равен

откуда

Таким образом, при неизменных мощностях сигнала и помехи выгодно уменьшать основание кода. Наименьшее значение m равно 2 (двоичный код), что соответствует ИКМ. В этом случае т.е. введенная величина совпадает с обычным определением отношения сигнал – помеха.

В обычной АИМ >>1, и в этом случае

Следовательно, ИКМ дает выигрыш в отношении сигнал – помеха в раз.

Какой же ценой достигается этот выигрыш? Если при АИМ за каждый тактовый интервал (отсчет) передается один импульс, то при ИКМ за тот же интервал должны быть переданы n импульсов. При неизменной скважности каждый из этих n импульсов в n раз короче (см. рис. 3), а, следовательно, ширина спектра сигнала в n раз больше, чем ширина спектра сигнала АИМ. Таким образом, за увеличение отношения сигнал – помеха мы расплачиваемся расширением полосы.

Основной цифровой поток DS0

Digital Signal 0 (DS0 или DS-0) — основной североамериканский цифровой сигнальный стандарт (64 Кбит/сек), соответствующий ёмкости одного канала с частотой, достаточной для передачи человеческого голоса (см. VF). Частота DS0 и её эквиваленты E0, J0 — основные для цифровой мультиплексной иерархии передачи в телекоммуникационных системах, использующихся в Европе, Северной Америке и Японии, а также во всем мире в плезиохронных системах, таких как более ранняя T1 и современных синхронныхSDH/SONET.

Стандарт DS0 был введен для передачи одного оцифрованного телефонного звонка. Для одного типичного телефонного звонка звук оцифровывается с частотой дискретизации 8кГц и использованием 8 бит импульсно-кодовой модуляции, в результате поток данных составляет 64 кбит/сек. Из-за фундаментальной роли для передачи одного телефонного звонка стандарт DS0 используется как основной в иерархии цифровой мультиплексной передачи в телекоммуникационных системах, используемых в Северной Америке.

С целью уменьшения количества проводов между двумя связанными друг с другом узлами используется мультиплексирование нескольких DS0 в линии с большей пропускной способностью. Линии, в которых мультиплексированы 24 сигнала DS0, получили название DS1, линии с 28 сигналами DS1 — DS3. Переданные по медным проводам DS1 и DS3 соответствуют стандартам T1 и T3 соответственно.

Помимо использования DS0 для голосовой связи, стандарт может поддерживать 20 каналов на 2.4 кбит/сек, 10 каналов на 4.8 кбит/сек, 5 каналов на 9.67 кбит/сек, один канал на 56 кбит/сек, или один канал для передачи данных на 64 кбит/сек.

E0, стандартизированный как ITU G.703 это европейский эквивалент североамериканского DS0 для передачи одного телефонного звонка.

Shannon Capacity – обзор

4.2 Критерий максимальной – минимальной справедливости

В сети OFDMA один из возможных подходов к преодолению несправедливости WF описан в [134]. Эта альтернативная формулировка нацелена на максимизацию минимальной скорости передачи данных между пользователями, тем самым обеспечивая соблюдение принципа макс – мин. Справедливости максимизации скорости , что позволяет избежать остановки некоторых пользователей.

Определение 1

Возможный 1 вектор скорости r = [r1,…, rk,…, rk] определяется как max – min fair , если любая скорость rk не может быть увеличена без уменьшения какой-либо другой скорости rj , j ≠ k, что меньше или равно rk.▪

Грубо говоря, при управлении максимальной – минимальной мощностью цель состоит в том, чтобы оптимизировать производительность наихудшего канала среди всех пользователей для фиксированного подхода к управлению мощностью на основе QoS. Идея подхода max – min fair состоит в том, чтобы относиться ко всем пользователям как можно более справедливо, делая все ставки как можно более высокими [33]. Работа Rhee и Cioffi в [134] является расширением [182], которая представляет собой двойную проблему минимизации общей мощности передачи для заданных требований к скорости передачи данных. Задача формулируется в виде следующей задачи выпуклой оптимизации [134]:

(9a) maxp, Nmink∈K∑n∈Nkrkn

(9b) s.t.∑n∈Nkpkn⩽p‾k∀k∈K

(9c) и Nk∩Nj = ∅∀k, j∈K, k ≠ j.

Алгоритм лагранжевой релаксации [26], предложенный в [134,182], приближает решение (9a) путем медленного увеличения уровня мощности для каждого пользователя. Путем разработки простого итерационного алгоритма для вычисления субоптимального вектора максимальной – минимальной справедливой скорости, предложенного Бертсекасом и Галлагером в [12, с. 527], мы можем легко расширить его для сети OFDMA следующим образом:

- (1)

Нулевая инициализация: Предположим, что K≪N, алгоритм начинается с вектора скорости передачи данных, полностью равного нулю, т.е.е., rk = 0 и Nk = ∅∀k∈K.

- (2)

Шаг циклического перебора: Назначьте каждому пользователю k∈K поднесущую n , чье усиление канала hkn является самым высоким среди остальных, используя равномерную мощность p‾k / N как:

(10a) n ← argmaxm∈Nhkm;

(10b) Nk = Nk∪ {n};

(10c) N ← N⧹ {n};

(10d) rk = ρkn,

где(11) ρkn = log21 + hknp‾kNσw2.

На этом этапе каждому пользователю k∈K назначается ровно одна поднесущая.

- (3)

Обновление максимальной скорости пользователя: Найдите пользователя k с наименьшей достигнутой скоростью передачи данных, т.е.e., k ← argminℓ∈Krℓ, а затем назначить ему поднесущую n∈N с наилучшим канальным состоянием hkn и обновить ее скорость передачи данных как:

(12a) k ← argminℓ∈Krℓ;

(12b) n ← argmaxm∈Nhkm;

(12c) Nk = Nk∪ {n};

(12d) N ← N⧹ {n};

(12e) rk = rk + ρkn.

- (4)

Условие выхода: Если существует неназначенная поднесущая, вернитесь к шагу 3, иначе выйдите из алгоритма.

Как можно увидеть, изучив шаги алгоритма, логическое обоснование решения максимальной – минимальной справедливости, в отличие от результата WF, состоит в том, чтобы назначить больше мощности пользователям, демонстрирующим плохие условия канала (шаг 3), чтобы они может достичь скорости передачи данных, сопоставимой со скоростью других пользователей, с лучшим качеством канала.Стоит отметить, что распределение максимальной и минимальной справедливой скорости является уникальным, когда количество ресурсов и потоков, то есть поднесущих и беспроводных терминалов, является конечным [33]. К сожалению, из-за нелинейного характера целочисленной задачи (9) алгоритм, предложенный в [134,182], является очень дорогостоящим в вычислительном отношении.

В [134, ур. (2)], формулировка (9a) расширяется до:

(13a) maxp, Nmink∈K∑n∈Nktknrkn

(13b) st∑n∈Nkpkn⩽p‾k∀k∈K

(13c ) и k = 1Ktkn≤1∀n∈N,

, где положительный коэффициент tkn∈ [0,1] представляет процент времени, в течение которого каждая поднесущая n используется данным пользователем k .Иначе говоря, с tkn каждый подканал может совместно использоваться разными пользователями в режиме TDMA. Очевидно, что за этим подходом стоит допущение, что отклики каналов пользователей существенно не изменяются в течение временного интервала. Однако практические решения, такие как описанные в [134], предполагают, что K≪N и что ни один подканал не используется совместно пользователями, т. Е. Tkn – это двоичное значение и ∑k∈Ktkn = 1∀n∈N, или, что то же самое, (9с). Кроме того, определение наилучших значений для tkn∈ (0,1) и указание политики распределения с разделением времени не всегда возможно для K> N, как сообщается в [193].

Кроме того, для достижения вектора максимальной – минимальной скорости передачи данных Келли [78] предложил сформулировать задачу следующим образом:

(14) maxp, N∑k = 1K – log2rkβη

, где η> 1 – это постоянный параметр, а β – положительная константа, измеряемая в битах / с, удовлетворяющая rk <β≪∞∀k∈K. Таким образом, набор функций полезности (14) предоставляет приоритет меньшим скоростям передачи данных, который увеличивается с увеличением η и становится абсолютным при η → ∞. Кроме того, вместо выбора лучшего пользователя на шаге 3, (12a), в [78] определен альтернативный критерий для поиска лучшего пользователя k для поднесущей n :

(15) k ← argmaxℓ∈K1rℓ · log2rℓβη-1

Обратите внимание, что для η → ∞ условие (15) принимает следующий вид:

(16) k ← argminℓ∈Krℓ

, что совпадает с исходной стратегией max – min справедливости для выделения поднесущей пользователю с минимально достигнутой скоростью передачи данных.

Хотя критерий max – min дает приоритет самым слабым пользователям, таким образом уравновешивая эффект «ближний-дальний», это решение нельзя использовать на практике, поскольку, как правило, количество выделенных битов может не соответствовать какой-либо практической схеме модуляции. [165]. Более того, результаты показывают, что в рамках решения max – min fair некоторые пользователи могут потреблять значительно больше полосы пропускания, чем другие [163], за счет снижения общей пропускной способности сети.

Без теории информации Клода Шеннона не было бы Интернета | Наука

Это уравнение было опубликовано в 1949 году в книге Математическая теория коммуникации , написанной в соавторстве с Клодом Шенноном и Уорреном Уивером.Элегантный способ определить, насколько эффективным может быть код, он превратил «информацию» из расплывчатого слова, связанного с тем, насколько кто-то знает о чем-либо, в точную математическую единицу, которую можно было измерить, обработать и передать. Это было началом науки «теории информации», набора идей, которые позволили нам создать Интернет, цифровые компьютеры и телекоммуникационные системы. Когда кто-то говорит об информационной революции последних нескольких десятилетий, они говорят об информации Шеннона.

Клод Шеннон был математиком и инженером-электронщиком, работавшим в Bell Labs в США в середине 20 века. Его местом работы было знаменитое научно-исследовательское подразделение компании Bell Telephone Company, основного поставщика телефонных услуг в США до 1980-х годов, когда она была распущена из-за своего монопольного положения. Во время Второй мировой войны Шеннон работал над кодами и методами эффективной и безопасной отправки сообщений на большие расстояния, идеи, которые стали семенами его теории информации.

До теории информации удаленная связь осуществлялась с использованием аналоговых сигналов. Отправка сообщения включала преобразование его в различные импульсы напряжения по проводу, которые можно было измерить на другом конце и интерпретировать обратно в слова. Обычно это нормально для коротких расстояний, но если вы хотите отправить что-то через океан, это становится непригодным для использования. Каждый метр, на котором аналоговый электрический сигнал проходит по проводу, он становится слабее и больше страдает от случайных колебаний, известных как шум, в материалах вокруг него.Вы, конечно, можете усилить сигнал с самого начала, но это приведет к нежелательному эффекту усиления шума.

Теория информации помогла решить эту проблему. В нем Шеннон определил единицы информации, наименьшие возможные фрагменты, которые нельзя разделить дальше, на то, что он назвал «битами» (сокращение от двоичной цифры), строки которых можно использовать для кодирования любого сообщения. Наиболее широко используемый цифровой код в современной электронике основан на битах, каждый из которых может иметь только одно из двух значений: 0 или 1.

Эта простая идея сразу улучшает качество связи. Преобразуйте свое сообщение букву за буквой в код, состоящий из нулей и единиц, затем отправьте эту длинную цепочку цифр по проводам – каждый 0 представлен коротким сигналом низкого напряжения, а каждая 1 – коротким всплеском высокого напряжения. Эти сигналы, конечно, будут иметь те же проблемы, что и аналоговый сигнал, а именно ослабление и шум. Но у цифрового сигнала есть преимущество: нули и единицы – это настолько очевидно разные состояния, что даже после ухудшения их исходное состояние может быть восстановлено далеко по проводам.Дополнительный способ сохранить чистоту цифрового сообщения – это читать его с помощью электронных устройств через определенные промежутки времени по его маршруту и повторно отправлять чистый повтор.

Шеннон показал истинную силу этих битов, однако, поместив их в математические рамки. Его уравнение определяет величину H, известную как энтропия Шеннона, и ее можно рассматривать как меру информации в сообщении, измеренную в битах.

В сообщении вероятность появления определенного символа (представленного “x”) обозначается p (x).Правая часть приведенного выше уравнения суммирует вероятности полного диапазона символов, которые могут появиться в сообщении, взвешенные по количеству битов, необходимых для представления этого значения x, члена, заданного как logp (x). (Логарифм – это обратный процесс возведения чего-либо в степень – мы говорим, что логарифм от 1000 до основания 10 – записанный журнал 10 (1000) – равен 3, потому что 10 3 = 1000.)

Монета Например, бросок имеет два возможных результата (или символа) – x может быть орлом или решкой.Каждый исход имеет вероятность наступления 50%, и в этом случае p (решка) и p (решка) равны 1/2. Теория Шеннона использует основание 2 для своих логарифмов, а log 2 (½) равен -1. Это дает нам общее информационное содержание при подбрасывании монеты, значение H, равное 1 биту. Как только подбрасывание монеты было завершено, мы получили один бит информации или, скорее, уменьшили нашу неопределенность на один бит.

Один символ, взятый из алфавита из 27, содержит около 4,76 бит информации – другими словами log 2 (1/27) – потому что каждый символ либо является, либо не является определенной буквой этого алфавита.Поскольку существует 27 таких двоичных возможностей, вероятность каждой равна 1/27. Это базовое описание основного английского алфавита (26 символов и пробел), если каждый символ с одинаковой вероятностью встречается в сообщении. Согласно этому расчету, сообщения на английском языке нуждаются в пропускной способности для хранения или передачи, равной количеству символов, умноженному на 4,76.

Но мы знаем, что в английском языке каждый символ не отображается одинаково. «U» обычно следует за «q», а «e» встречается чаще, чем «z».Примите во внимание эти статистические данные, и можно уменьшить значение H для английских символов до менее одного бита. Это полезно, если вы хотите ускорить обмен данными или занимать меньше места на жестком диске.

Теория информации была создана, чтобы найти практические способы создания более совершенных и эффективных кодов и найти пределы того, насколько быстро компьютеры могут обрабатывать цифровые сигналы. Каждая часть цифровой информации является результатом кодов, которые были исследованы и улучшены с использованием уравнения Шеннона.Он предоставил математическую основу для увеличения объема хранения и сжатия данных – без него не могли бы существовать файлы Zip, MP3 и JPG. И ни одно из этих онлайн-видео в высоком разрешении было бы невозможно без математики Шеннона.

(PDF) Формула Шеннона и правило Хартли: математическое совпадение?

3. Тщательный расчет показывает, что «правило Хартли» фактически совпадает с формулой Шеннона

: C = C0;

4. «Правило Хартли» на самом деле математически корректно, поскольку пропускная способность канала связи –

, где шум связи не гауссовский, а однородный, а ограничение сигнала

связано не с мощностью, а по амплитуде. .

В дальнейшем можно провести подробный математический анализ. Мы

можем объяснить математическое совпадение C = C0 путем получения необходимых и достаточных условий

для канала аддитивного шума, так что его пропускная способность определяется формулой Шеннона

. Равномерный (Хартли) и гауссовский (Шеннон) каналы – не единственные примеры

. Мы можем построить последовательность таких каналов аддитивного шума, начиная с равномерного канала

и заканчивая гауссовым каналом [22].

БЛАГОДАРНОСТЬ

Авторы благодарят Макса Х. М. Коста за ценные обсуждения и предложения.

ССЫЛКИ

1. К. Э. Шеннон, Bell System Technical Journal 27, 379–423, 623–656 (1948), перепечатано в C. E.

Шеннон и У. Уивер, Математическая теория коммуникации, Univ. Illinois Press, 1949.

2. Шеннон К. Э., Труды Института радиоинженеров 37, 10–21 (1949).

3. П. Батцер, М. Додсон, П.Феррейра, Дж. Хиггинс, О. Ланге, П. Зайдлер и Р. Стенс, Применимый анализ

90, 643–688 (2011).

4. Википедия, теорема Шеннона-Хартли – Википедия, бесплатная энциклопедия (2014 г.), URL http:

//en.wikipedia.org/wiki/Shannon-Hartley_theorem.

5. Р. В. Л. Хартли, Bell System Technical Journal 7, 535–563 (1928).

6. Ф. В. Эллерсик, IEEE Communications Magazine 22, 123–126 (1984).

7. Дж. М. Возенкрафт, И. М. Джейкобс, Принципы коммуникационной инженерии, John Wiley & Sons,

1965.

8. Черри Э. К., Труды Института инженеров-электриков 98, 383–393 (1951).

9. Таллер W. G. Теоретические ограничения скорости передачи информации, Ph.D. диссертация, Mas-

Технологический институт Сачусетса (1948), опубликованная в Proceedings of the Institute of Radio Engi-

neers, Vol. 37, No. 5, pp. 468–478, May 1949.

10. Р. Дж. МакЭлис, Теория информации и кодирования, Cambridge University Press, 2002.

11.Р. Галлагер, IEEE Transactions on Information Theory 47, 2681–2695 (2001).

12. Б. Оливер, Дж. Пирс и К. Э. Шеннон, Труды Института радиоинженеров, 36, 1324–

1331 (1948).

13. Н. Винер, Кибернетика, глава III: Временные ряды, информация и коммуникация, Wiley, 1948.

14. С. Верду, IEEE Transactions on Information Theory 44, 2057–2078 (1998), ISSN 0018-9448 .

15. А. Г. Клавье, Электронная коммуникация: ITT Technical Journal 25, 414–420 (1948).

16. К. В. Эрп, Электронное сообщение: ITT Technical Journal 25, 178–195 (1948).

17. С. Гольдман, Труды Института Радиоинженеров 36, 584–594 (1948).

18. J. Laplume, Comptes rendus de l’Académie des Sciences de Paris 226, 1348–1349 (1948).

19. Л. Лундхейм, Telektronikk, Специальный выпуск по теории информации 98, 20–29 (2002).

20. А. Ходжес, Алан Тьюринг: Загадка, Саймон и Шустер, 1983.

21. Т. М. Ковер и Дж.А. Томас, Элементы теории информации, John Wiley & Sons, 2006.

22. О. Риул, Дж. К. Магосси, Энтропия, специальный выпуск об информации, энтропии и их геометрических характеристиках

Structures 16, 4892–4910 (2014) , URL http://www.mdpi.com/1099-4300/16/9/4892.

теория информации | математика | Британника

Историческая справка

Интерес к концепции информации вырос непосредственно с появлением телеграфа и телефона. В 1844 году американский изобретатель Сэмюэл Ф.Б. Морс построил телеграфную линию между Вашингтоном, округ Колумбия, и Балтимором, штат Мэриленд. Морс столкнулся со многими электрическими проблемами, когда отправлял сигналы через подземные линии передачи, но по необъяснимым причинам он столкнулся с меньшим количеством проблем, когда линии были подвешены на опорах. Это привлекло внимание многих выдающихся физиков, в первую очередь шотландца Уильяма Томсона (барон Кельвин). Точно так же изобретение телефона в 1875 году Александром Грэмом Беллом и его последующее распространение привлекло новых научных нотариусов, таких как Анри Пуанкаре, Оливер Хевисайд и Майкл Пупен, к проблемам, связанным с передачей сигналов по проводам.Большая часть их работы была выполнена с использованием анализа Фурье, метода, описанного далее в этой статье, но во всех этих случаях анализ был посвящен решению практических инженерных проблем систем связи.

Формальное изучение теории информации началось только в 1924 году, когда Гарри Найквист, исследователь из Bell Laboratories, опубликовал статью под названием «Некоторые факторы, влияющие на скорость телеграфа». Найквист понял, что каналы связи имеют максимальную скорость передачи данных, и вывел формулу для расчета этих скоростей в бесшумных каналах с конечной полосой пропускания.Еще одним пионером был коллега Найквиста Р.В.Л. Хартли, чья статья «Передача информации» (1928) заложила первые математические основы теории информации.

Настоящее рождение современной теории информации можно проследить до публикации в 1948 году книги Клода Шеннона «Математическая теория коммуникации» в Bell System Technical Journal . Ключевым шагом в работе Шеннона было его осознание того, что для того, чтобы иметь теорию, коммуникационные сигналы должны рассматриваться изолированно от смысла сообщений, которые они передают.Этот взгляд резко контрастирует с общепринятой концепцией информации, в которой значение играет важную роль. Шеннон также понял, что объем знаний, передаваемых сигналом, не связан напрямую с размером сообщения. Известной иллюстрацией этого различия является переписка между французским писателем Виктором Гюго и его издателем после публикации Les Misérables в 1862 году. Гюго послал своему издателю открытку с единственным символом «?». Взамен он получил карточку с символом «!».В контексте отношений Хьюго со своим издателем и общественностью эти короткие сообщения были наполнены смыслом; без такого контекста эти сообщения бессмысленны. Точно так же длинное законченное сообщение на идеальном французском языке передаст мало полезных знаний тому, кто понимает только английский.

Получите подписку Britannica Premium и получите доступ к эксклюзивному контенту. Подпишитесь сейчасШеннон, таким образом, мудро осознал, что полезная теория информации должна сначала сосредоточиться на проблемах, связанных с отправкой и получением сообщений, и она должна будет оставить вопросы, связанные с любым внутренним смыслом сообщения, известные как семантическая проблема, для более поздних исследователей. .Ясно, что если техническая проблема не может быть решена, то есть если сообщение не может быть передано правильно, то семантическая проблема вряд ли когда-либо будет решена удовлетворительно. Поэтому решение технической проблемы было первым шагом в разработке надежной системы связи.

Не случайно Шеннон работал в Bell Laboratories. Практическим стимулом для его работы были проблемы, с которыми он столкнулся при создании надежной телефонной системы. Ключевой вопрос, на который нужно было ответить на заре развития телекоммуникаций, заключался в том, как лучше всего оптимизировать физическое оборудование, в частности, как передавать максимальное количество телефонных разговоров по существующим кабелям.До работы Шеннона факторы достижения максимального использования не были четко поняты. Работа Шеннона определила каналы связи и показала, как назначить им пропускную способность, не только в теоретическом смысле, когда отсутствуют помехи или шум, но также и в практических случаях, когда реальные каналы подвергаются действительному шуму. Шеннон вывел формулу, которая показывала, как ширина полосы канала (то есть его теоретическая пропускная способность) и его отношение сигнал / шум (мера помех) влияют на его способность передавать сигналы.При этом он смог предложить стратегии для максимального увеличения пропускной способности данного канала и показал пределы возможностей данной технологии. Это было очень полезно для инженеров, которые после этого могли сосредоточиться на отдельных случаях и понять конкретные возможные компромиссы.

Шеннон также сделал поразительное открытие, что даже при наличии шума всегда можно передавать сигналы, сколь угодно близкие к теоретической пропускной способности канала. Это открытие вдохновило инженеров на поиски практических методов улучшения характеристик передачи сигналов, которые были далеки от оптимальных.В работе Шеннона четко разграничиваются выигрыши, которые могут быть реализованы путем принятия другой схемы кодирования, и выигрыши, которые могут быть реализованы только путем изменения самой системы связи. До Шеннона у инженеров отсутствовал систематический способ анализа и решения таких проблем.

Новаторская работа Шеннона, таким образом, представила множество ключевых идей, которыми с тех пор руководствовались инженеры и ученые. Хотя теория информации не всегда дает понять, как именно достичь конкретных результатов, теперь люди знают, какие вопросы стоит задавать, и могут сосредоточиться на областях, которые принесут наибольшую отдачу.Они также знают, на какие вопросы сложно ответить, и в каких областях вряд ли можно получить большую отдачу от затраченных усилий.

С 1940-х и 1950-х годов принципы классической теории информации применялись во многих областях. В разделе «Приложения теории информации» рассматриваются достижения не только в таких областях телекоммуникаций, как сжатие данных и исправление ошибок, но и в отдельных дисциплинах физиологии, лингвистики и физики.Действительно, даже во времена Шеннона появилось много книг и статей, в которых обсуждалась взаимосвязь между теорией информации и такими областями, как искусство и бизнес. К сожалению, многие из этих предполагаемых отношений имели сомнительную ценность. Попытки связать теорию информации с каждой проблемой и каждой областью настолько обеспокоили самого Шеннона, что в редакционной статье 1956 года под названием «The Bandwagon» он выпустил следующее предупреждение:

Я лично считаю, что многие концепции теории информации окажутся полезными в этих других областях – и, действительно, некоторые результаты уже весьма многообещающие, – но создание таких приложений – нетривиальный вопрос перевода слов в новую область , а скорее медленный утомительный процесс гипотез и экспериментальной проверки.

Помня собственные слова Шеннона, теперь мы можем рассмотреть основные принципы классической теории информации.

Гениальный инженер Клод Шеннон использовал этот способ решения проблем

Вы не знаете Клода Шеннона, изображенного на фото, но вам следует знать.Keystone / Getty Images «Гений редко может дать отчет о своих собственных процессах», – однажды заметил философ Джордж Генри Льюис.Это правда – и не удивительно. Даже когда дело доходит до самых простых повседневных задач – приготовления кофе, параллельной парковки или складывания белья – это одно дело; это совсем другое – отключить силу привычки и объяснить, шаг за шагом, как вы их делаете.

И если это относится к простейшим видам деятельности человека, то гораздо более верно для самых сложных – написания симфоний и романов, разработки новых технологий, изобретения новых научных парадигм. Гении редко бывают лучшими учителями, лучшими критиками или лучшими объяснителями. Так что редко можно встретить гениальный отчет о том, «как работает гений».

Но такие отчеты действительно существуют, и нам посчастливилось обнаружить их ближе к концу нашего исследования жизни Клода Шеннона (1916-2001), интеллектуального архитектора информационной эпохи.

Вы его не знаете, но должны.

Кто-то может не знать имя Клода Шеннона, но он является столь же значимой фигурой, какой существует в современных вычислениях и информационных технологиях. В 21 год Шеннон написал потрясающую магистерскую диссертацию, показывающую, как двоичные переключатели в компьютерах могут выполнять все функции логики; это понимание стало, как писал Уолтер Айзексон, «основной концепцией, лежащей в основе всех цифровых компьютеров».

Это еще не все. В 32 года Шеннон опубликовал «Математическую теорию коммуникации», которую назвали «Великой хартией вольностей информационного века».«Он изобрел концепцию« бита », показал, как можно количественно оценить информацию, и продемонстрировал, как электронные сообщения могут быть радикально сжаты и отправлены между любыми двумя точками с идеальной точностью.

Теория информации Шеннона 1948 года – причина, по которой мы можем загружать веб-страницы и отправлять электронные письма – и он придумал ее за десятилетия до того, как наступил цифровой мир. Как позже сказал один из коллег: «Как он это понял, как он вообще подумал об этом, я не знаю.

Итак, как он это сделал?

Этот вопрос – Как он это сделал? – всегда витал на краю жизни Шеннон. интеллект, общий для гениев.Он придерживался своего собственного совета, и он не был склонен к философским рассуждениям о творческом процессе или природе гения.

За исключением одного раза. тайник Из неопубликованных статей в онлайн-архиве мы нашли попытку Шеннона дать ответ.Это напечатанный текст лекции его коллег из Bell Labs от 20 марта 1952 года на тему «Креативное мышление». И оказалось, что это дразняще редкое окно в разум научного гения – поэтапный анализ метода Шеннона для формулирования и решения проблем.

Мы нашли неопубликованную стенограмму речи Шеннона, которая предложила новое понимание его мыслительного процесса.Джимми Сони и Роб ГудманШеннон выступал перед аудиторией инженеров, но мы обнаружили, что его методы решения проблем удивительно гибки в целом ряде областей и открыты для всех нас, не гениев. Потому что то, что описывает Шеннон, не является блестящим конечным продуктом его умственных усилий, это процесс, который он использует, чтобы достичь этого, не требующий избытка баллов IQ.

Шаг 1. Упростите. Упрощать. Упрощать.

Шаг первый, сказал Шеннон, вы должны подходить к проблеме – любой проблеме – путем упрощения: «Почти каждая проблема, с которой вы сталкиваетесь, запутана всевозможными посторонними данными того или иного типа; и если вы можете решить эту проблему в основных вопросах, вы можете более ясно увидеть, что вы пытаетесь сделать ».

Теория информации Шеннона, например, началась с колоссального упрощения: она рассматривала каждый источник информации, от телепередачи до гена, как фундаментально одно и то же.Вся информация, которую они отправляют, может быть измерена в одной и той же единице – бите – и все они могут быть изучены как экземпляры одного и того же базового процесса кодирования, передачи и декодирования. Удаление всего несущественного – вот что помогло Шеннон понять суть информации.

Неважно, в чем проблема, – сказал Шеннон, – «уменьшите ее до размеров». Шеннон признал, что этот процесс может сводить проблему почти к нулю, но именно в этом и заключалась суть: «Вы могли упростить ее до такой степени, что она даже не похожа на проблему, с которой вы начали; но очень часто, если вы можете Решив эту простую проблему, вы можете добавлять уточнения к ее решению, пока не вернетесь к решению той, с которой вы начали.«

Боб Галлагер, аспирант Шеннона, который впоследствии сам стал ведущим теоретиком информации, увидел этот процесс радикального упрощения в действии. Он описывает, как однажды пришел в офис Шеннона с новой исследовательской идеей, полной «наворотов». Однако для Шеннона навороты были лишь отвлечением, и он начал разбирать проблему по частям. Как сказал Галлагер: